我们选择对2026年发表在《美国社会信息科学和技术杂志》上的177篇文章组成的数据集进行分析,以此为例讲述文本挖掘技术在文献计量学研究中的应用。我们提取了每篇文章的标题和摘要用来做进一步的分析。我们对2026年发表在《美国社会信息科学和技术杂志》上的论文概念做一个概况分析,并且突出在该期刊上最频繁出现的概念,以建立一个2026年全年研究的总体趋势。

除Stanford CoreNLP软件外,我们还使用Metrics Conversion Handler程序和Gephi对研究结果进行可视化处理。这两个软件都是开源的,下载网址分别如下:http://informatics.yonsei.ac.kr/stanford_metrics/stanford_metrics.zip,https://gephi.org/。

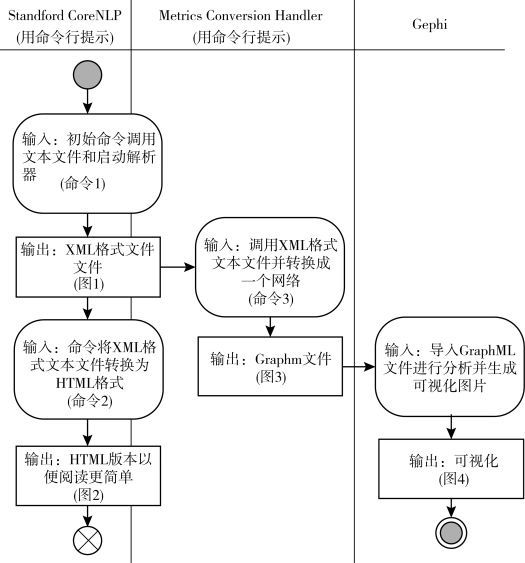

工作流程如图10.1所示,先使用Stanford CoreNLP对jasist_2012.txt进行文本分析,该文本包含上面提及的2026年发表于JASIST所有论文的题目和摘要。然后使用MetricsConversionHandler把从Stanford CoreNLP输出的文件转换成网络文件,最后用Gephi打开网络文件,确定关联性最强和最重要的节点,最终创建一个描述jasist_2012.txt主题内容的可视化图谱。

图10.1 从文本文件到可视化的工作流程

Stanford CoreNLP软件工作流程:下载和解压该文件后,需要打开一个命令行,并且将路径改变为解压文件的文件夹,接着使用命令(1)启动Stanford CoreNLP程序。

命令(1)如下:Java-cp stanford-corenlp-3.3.0.jar;stanfordcorenlp-3.3.0-models.jar;xom.jar;joda-time.jar;jollyday.jar-Xmx3gedu.stanford.nlp.pipeline.StanfordCoreNLP-annotatorstokenize,ssplit,pos,lemma,ner,parse,dcoref-file jasist_2012.txt。

命令(1)的第一部分“Java-cp stanford-corenlp-3.3.0.jar;stanford-corenlp-3.3.0-models.jar;xom.jar;joda-time.jar;jollyday.jar-Xmx3gedu.stanford.nlp.pipeline.StanfordCoreNLP”调用java和特定的jars文件来执行程序。选项“-Xmx3g”指定Java所需的计算机内存。在64位计算机上通常需要3GB的空间才能运行Stanford CoreNLP软件,并且空间大小取决于所分析文件的大小。对于Windows系统,要用分号“;”分隔jars文件,而在Mac OSX系统或者Linux系统中,执行相同的功能需要用冒号“:”。命令(1)接下来的一部分,“-annotators tokenize,ssplit,pos,lemma,ner,parse,dcoref”用来指定分析文本所用的注释器。当使用标准注释器时,这个命令不是强制性的,这是由于代码会使用内置特性文件,该文件使用下面这些默认注释器:tokenization及sentence splitting、POS tagging、lemmatization、NER、parsing和coreference resolution。还有其他注释器罗列在表10.1上,并且在Stanford CoreNLP网站上能够找到这些注释器的使用说明(http://nlp.stanford.edu/downloads/corenlp.shtml)。命令(1)的最后一部分,“-file jasist_2012.txt”是指要调用的文件,在这个例子中是jasist_2012.txt。

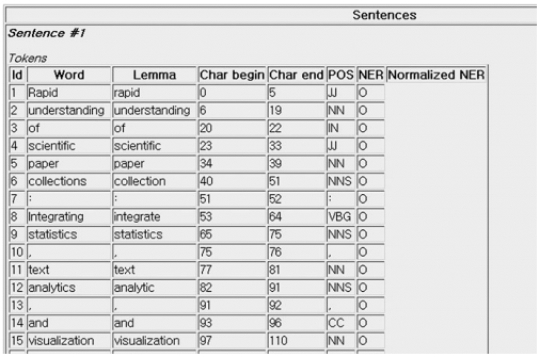

在成功执行后,在同一文件夹内生成XML文件,文件名与输入文件的名字相同,但其扩展名为.xml。对于每一个输入的文件,Stanford CoreNLP软件默认生成一个带有所有相关注释的XML文件。例如,图10.2中jasist_2012.txt的输出文件含有由Stanford CoreNLP处理的每个“token”:①Word;②Lemma;③Part of Speech(POS);④Named Entity Recognition(NER)。单词“token”用于识别在句子中被空格键分开的单词。Lemma token用于识别单词的规范形式,例如retrieves、retrieved和retrieving这三个词具有相同的词元:retrieve。POS token是单词的语言学类别,一般根据单词在句子中的语法和形态对其进行定义,如名词、动词。NER token把单词当作一个预定类别的实体,例如,人名、组织、位置。NER的常见结果是一组实体名称的集合,每个名称都对应从句子中提取的有意义的单词。

接下来,生成的XML文件可交由CoreNLP-to-HTML.xsl处理,并转化成简单易读的HTML文件。完成这一过程需要在命令窗口里运行命令(2),运行方式与之前的执行命令相似。

命令(2)如下:org.apache.xalan.xslt.Process-in jasist_2012.txt.xml-xsl CoreNLP-to-HTML.xsl-out jasist_2012.html。

(https://www.daowen.com)

(https://www.daowen.com)

图10.2 Stanford CoreNLP软件解析jasist_2012.txt生成的XML文件

请注意,命令(2)中“-in”命令调用先前生成的jasist_2012.txt.xml文件,“-out”命令输出新命名的jasist_2012.html文件。该命令中使用的xsl样式表为Stanford CoreNLP软件的标准配置,它可使XML内容以可阅读的方式展示。图10.3显示了jasist_2012文件用HTML格式表示的结果。

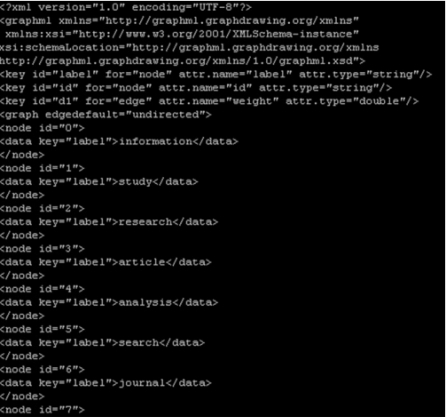

MetricsConversionHandler软件:为了利用上面的结果进行文献计量学研究,我们选择使用MetricsConversionHandler,这个软件能够转化Stanford CoreNLP输出的XML文件。MetricsConversion Handler软件首先利用SAX处理技术读取XML文件,然后选择名词和Lemma格式作为输入文件并用XML输出中的POS和Lamma进行共词分析。然后这个软件计算每句中的词对数并生成一个GraphML文件。图10.4是文件jasist_2012.txt.xml的生成文件。

图10.3 jasist_2012文件从XML转换成HTML格式的输出结果

MetricsConversionHandler软件可以从下面这个网站下载:http://informatics.yonsei.ac.kr/stanford_metrics/stanford_metrics.zip。对软件进行解压后,我们需要在命令行运行命令(3)以生成相应的GraphML文件:

命令(3)如下:java-Xms64m-Xmx2550m-cp.:./build:./bin:./lib/edu.yonsei.metrics.MetricsConversion Handler jasist_2012.txt.xml jasist_2012.graphml。

再次注意,MetricsConversionHandler程序需要调用由Stanford CoreNLP生成的XML文件并生成一个同名的GraphML文件。然后此文件(此例中为jasist_2012.graphml)可作为Gephi可视化程序的输入文件,用于进一步分析和对共词网络进行可视化。

图10.4 MetricsConversionHandler程序生成的GraphML文件

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。