专座智能提示方法包括训练样本学习与在线识别两大步骤。

1.训练样本学习

所谓训练样本学习,即系统进入在线运行前必须进行的样本学习训练。当系统处于学习状态时,系统对16~55周岁年龄段的乘客脸部及其身体形态图像进行采集与处理。训练样本学习包含以下7个分步骤。

(1)采集中青年乘客脸部及其身体形态图像并进行彩色空间转换。

将针孔摄像头抽样采集到的中青年乘客脸部及其身体形态图像进行强化后,再将其从RGB彩色空间转换至HSV彩色空间进行表达,即连续采集多幅图像,包括16~55周岁不同年龄段的乘客脸部及其身体形态与不同表情特征的脸部图像,再将每幅强化后的图像从RGB彩色空间转换至HSV彩色空间进行表达。

(2)将中青年乘客脸部及其身体形态与背景区分开来。

这一过程侧重在抽样采集到的中青年乘客脸部图像中,按照像素坐标从左至右、从上到下地扫描检测像素的景物色调,并将落入HSV彩色空间中的色调区间[2°,47°]的色调集合所对应的像素点拟定为人脸区域,因此就能将青壮年脸部图像中其他区域及背景与脸部区域准确地区分开来。这是因为人物图像中的人脸肤色与衣物及背景存在明显不同的色调差别,人脸肤色与衣物及背景各自的色调分布于不同的角度区域,而且人脸肤色的色调相对稳定地集中在HSV彩色空间中的某个角度区域,通过实验证实不论是自然光照射还是人工光源照射,也不论摄像系统的异同,肤色的色调H的角度分布都基本保持在HSV彩色空间的2°~47°之间,因此能够通过人物图像在HSV空间中的色调值来区分出人脸肤色和衣物、背景及其他景物。实验进一步证实,人脸肤色的色调值为11°的概率最高,因此称11°的色调值为人脸肤色的概率峰值。令人脸肤色色调在区间[2°,47°]的分布概率为P(H)时,则H=11°的概率达到最高,即P(11°)=Pmax,也就是说,当某个景物的色调为11°时,认定该景物为人脸肤色的置信度达到最高。

(3)确定抽样采集到的中青年乘客脸部图像的中心位置与脸部区域。

利用抽样采集到的中青年乘客脸部图像的HSV彩色空间表达,在人脸肤色色调集合中,将最接近11°的色调值所对应的像素点坐标作为人脸中心点,如经过人脸区域搜寻结果,获得落入HSV彩色空间中的色调区间[2°,47°]的色调集合为{…,9.7°,10.1°,9.5°,…},而且该集合所对应的像素点坐标为{…,(ik-1,jk-1),(ik,jk),(ik+1,jk+1),…},其中最接近11°的色调值是10.1°,所对应的像素点坐标为(ik,jk),因此就可以确定(ik,jk)为人脸中心位置坐标,i表示像素的列坐标,j表示像素的行坐标,下标表示列数和行数,ik的k表示第k列,jk的k表示第k行。并以人脸中心点为基点向上、下各扩张![]() 行像素和向左、右各扩张

行像素和向左、右各扩张![]() 列像素,作为u×v大小的脸部区域,简称u×v脸部区域。

列像素,作为u×v大小的脸部区域,简称u×v脸部区域。

(4)导入中青年乘客脸部区域图像训练样本。

截取中青年乘客脸部图像u×v脸部区域后作为训练样本导入样本训练系统数据库。所采集的中青年乘客脸部图像的u×v脸部区域训练样本均具有256个灰度级,一般取训练样本数n=k×l≥300;其中,k、l分别为被采样青壮年数和每个中青年乘客被采样脸部区域的样本数,如k=30、l=10分别代表被采样青壮年数为30个、每个中青年乘客被采样脸部区域的样本数为10。

(5)将训练样本图像转换为一维向量。

将每一个二维的中青年乘客脸部区域训练样本图像数据转化为一维的向量,并定义中青年乘客脸部特征为1类脸部特征,其余人的脸部特征为-1类脸部特征。所述的“其余人”包括小孩、老人、妇女等。可以表达出1类第i图像的一维向量xi为

![]()

式中,xij表示1类第i个样本第j个像素灰度值;i=1,2,…,n为1类脸部区域样本序号;j=1,2,…,m为每个样本图像所取像素数,m=u×v,u和v分别为样本图像的列和行像素数。

(6)计算训练样本特征值及特征向量。

计算1类的均值 ,即

,即

称由此求得的均值 为1类平均脸。

为1类平均脸。

对上述训练样本进行规范化后可以表达为

![]()

由训练样本组成的1类平均脸规范化向量v,则

![]()

此时,1类平均脸协方差矩阵为

![]()

利用式(6-11)求取Q的特征值λl及其特征向量,并将其从大到小重新排列后生成特征向量

![]()

其中,λ1≥λ2≥λ3≥…。

(7)建立人脸特征判据。

由于较大的特征值对应的特征向量包含较多的人脸特征信息,因此选取前s个较大的特征值所对应的特征向量构成的向量空间就可以近似地表示人脸图像的主要信息。s取值由实验确定。

从v=[v1 v2 Kvn]T中选取前s个较大的特征值所对应的规范化值构成新的规范化向量为

![]()

因此,可以直接用v来代表1类人脸特征,即中青年乘客脸部区域特征。这就是说,建立了人脸特征规范化向量后,就可以依次作为识别当前乘客是否为中青年乘客的判据。式(6-8)~式(6-13)的计算过程又称为脸部图像对特征空间的投影。

(8)对1类人脸特征再建立女性特征规范化向量。

所谓“对1类人脸特征再建立女性特征规范化向量”,即在获得第一层次的1类人脸特征向量后,重复上述(1)~(7)的步骤,再对1类人脸特征中做出女性与男性的区分,即区分出“1类人脸特征”向量中的女性特征元素,建立“1类人脸特征”的“女性特征”2类特征分向量。即由式(6-13)分解出2类特征分向量

![]()

余下便是1类中的男性特征分向量

![]()

式中,k为s所处区间的任意值,可以取k=![]()

(9)对2类特征再区分是否孕妇。

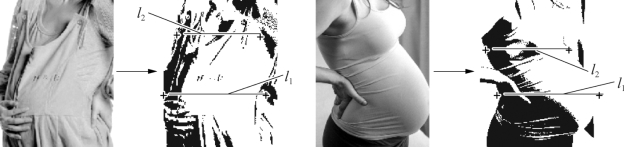

对2类特征者再进行身体形态甄别,即对其身体形态图像求取“孕妇形态”特征点及其特征向量。确定“孕妇形态”特征点的技术要点在于,身体轮廓主要特征点间连线长度的相互比例关系。如图6-8所示,孕妇体型具有明显特征曲线,其相应特征点连线即构成某种特定的比例关系,即

(https://www.daowen.com)

(https://www.daowen.com)

式中,ε2为判定阈值,只要某位女性乘客的特征比例尺大于该判定阈值,即可确认该为女性乘客为孕妇。

图6-8孕妇体型特征曲线及其特征点连线

2.在线识别

当上述地铁专座智能提示装置系统进入(处于)在线工作状态时,对爱心专座上的乘客实施实时监视,根据识别结果对专座上的乘客确定控制指令输出,决定是否由语音提示器向该乘客提示。其整个过程由以下分步骤。

(1)在线采集专座上的乘客脸部位置图像并进行彩色空间转换。

将针孔摄像头实时采集到的专座上的乘客脸部位置图像进行强化后,再将其从RGB彩色空间转换至HSV彩色空间进行表达。乘客脸部位置图像包括专座上有乘客、没有乘客或该专座被遮挡时的图像。

(2)将专座上的乘客脸部图像与背景区分开来。

在采集到的专座上的乘客脸部位置图像中,按照像素坐标从左至右、从上到下地扫描检测像素的景物色调,将落入HSV彩色空间中的色调区间[2°,47°]的色调集合所对应的像素点拟定为人脸区域,如果能够找到对应色调区间[2°,47°]的像素点,则说明专座上有乘客乘坐,因此将专座上乘客的其他区域图像及其背景及脸部区域准确地区分开来。继续下一分步骤(3)。

如果没有找到能够落入HSV色调区间[2°,47°]色调所对应的像素点,则表明当前专座上尚未有人乘坐,或者是针孔摄像头的视场暂时被车厢内站立者的身体部位遮挡。此时,运算程序回到上述分步骤(1),继续监视专座上的状态。

(3)对采集到的专座上的乘客脸部图像进行人脸中心位置与眼部区域确定。

利用人脸的HSV彩色空间表达,将最接近11°的色调值所对应的像素点坐标作为人脸中心点,并以人脸中心点为基点向上、下各扩张![]() 行像素和向左、右各扩张

行像素和向左、右各扩张![]() 列像素,作为u×v大小的脸部区域,简称u×v脸部区域,即可获取u×v的脸部跟踪区域。

列像素,作为u×v大小的脸部区域,简称u×v脸部区域,即可获取u×v的脸部跟踪区域。

(4)对专座上乘客脸部区域进行跟踪。

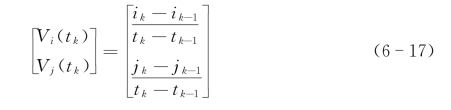

将一阶预测算法作为专座上乘客脸部区域跟踪的方法,设当前专座乘客脸部运动速度为V(tk)=[Vi(tk)Vj(tk)]T,且

即采用间隔时间为Δt条件下,对人脸中心位置的前后两次运算来求取Δt=tk-tk-1。

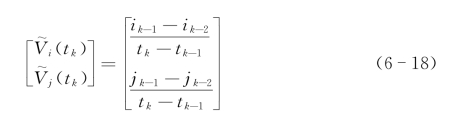

其一阶预测估计值应为

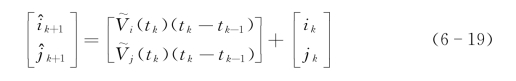

预测专座上乘客脸部目标的像素坐标为

式中,Vi(tk)与Vj(tk)分别为第k时刻速度V(tk)在像素坐标系中i和j两个坐标轴上的分量;![]() 分别为第k时刻速度V(tk)在i和j两个坐标轴上的分量估计值;ik、ik-1与ik-2分别为第k、第k-1和第k-2时刻的i坐标值;jk、jk-1与jk-2分别为第k、第k-1和第k-2时刻的v坐标值;

分别为第k时刻速度V(tk)在i和j两个坐标轴上的分量估计值;ik、ik-1与ik-2分别为第k、第k-1和第k-2时刻的i坐标值;jk、jk-1与jk-2分别为第k、第k-1和第k-2时刻的v坐标值;![]() 与

与![]() 分别为第k+1时刻i和j的坐标估计值。

分别为第k+1时刻i和j的坐标估计值。

因此,当第k时刻tk的人脸中心为(ik,jk)时,能够通过一阶预测算法预测出爱心专座乘客脸部在第k+1时刻tk+1的人脸中心为(![]() )。

)。

(5)导入测试样本。

根据系统跟踪到的人脸中心坐标(ik,jk),依次向上、下各扩张![]() 行像素和向左、右各扩张

行像素和向左、右各扩张![]() 列像素,截取u×v脸部区域作为爱心专座乘客脸部区域的测试样本,并将其导入识别系统。

列像素,截取u×v脸部区域作为爱心专座乘客脸部区域的测试样本,并将其导入识别系统。

(6)计算测试样本的特征向量。

重复利用式(6-8)~式(6-13)的运算,完成对测试样本的图像特征值及其特征向量的计算,从v=[v1v2…vn]T中选取前s个较大的特征值所对应的规范化值构成新的规范化向量

![]()

因此,可以直接用 来代表专座上当前乘客脸部区域特征,即测试样本特征规范化向量。

来代表专座上当前乘客脸部区域特征,即测试样本特征规范化向量。

(7)类型识别。

识别专座上的乘客类别,将投影到特征空间中的u×v脸部区域特征 与训练样本特征

与训练样本特征 通过距离分类函数进行比较,确定待识别样本的所属类别,即

通过距离分类函数进行比较,确定待识别样本的所属类别,即

![]()

说明:当前专座上的乘客属于1类;否则,当前专座上的乘客属于-1类。

在式(6-21)中, 、

、 分别代表测试样本和训练样本脸部特征规范化向量。

分别代表测试样本和训练样本脸部特征规范化向量。

(8)类型进一步细分。

对属于1类的乘客尚需进一步区分是否属于2类而排除1类中的男性乘客。重复上述步骤(1)~(7),将被识别对象再与2类特征向量进行匹配。如果不属于2类,则转向步骤(10);否则,继续步骤(9)。

(9)特征点测算。

提取目标图像的形态特征点,并对其关键特征点连线相互之间的比例进行测算,用以确定是否属于2类,如果![]() >ε2,则认定其为孕妇,返回步骤(1);否则,继续步骤(10)。

>ε2,则认定其为孕妇,返回步骤(1);否则,继续步骤(10)。

(10)控制决策。

根据识别结果对当前专座上乘客确定输出控制指令,即一旦判定专座上的乘客为“青壮年男性”或其他“非孕妇中青年女性”时,系统实时输出控制指令,在控制指令的驱动下,语音提示器向被识别目标乘客发出友好提示:“这是爱心专座,请您将它让给需要帮助的乘客好吗?谢谢您的帮助!”否则,系统不会发出提示(包括专座上无人乘坐的情况)。

从步骤(1)到步骤(10)循环运算,对专座进行在线实时识别,实现对专座的全程监视。

如果被识别对象出现“青壮年男性”或其他“非孕妇中青年女性”却是患病乘客或是残疾人的情况时,仍然可以通过语音识别等其他方式得以“修正”。如只要有人(包括本人或周边乘客)说“他(她)身体患病……”,系统立即予以“修正”,并播送关怀之语。

当然,地铁车厢的通道上时常都会有人站立其间,此时又如何采集和识别爱心专座上乘客的图像呢?一旦爱心专座被长期遮挡,只要有人员移动,哪怕只有瞬间的间隙,爱心专座上的图像信息就会被实时地捕捉到。所以,该项技术又称为永不疲劳、从不眨眼的单目视感器,对创造舒适、和谐的乘车环境起到了非技术方式所无法起到的积极作用[75]。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。