模板匹配(template matching)算法是对前方物体进行快速识别的有效方法之一[29]。

1.特征点状态识别理论

1)算法原理

通过车载摄像头1、2(见图2-9、图2-13)实时采集轨道前方景物图像,并始终将当前图像与前一时刻采集的图像进行对比。所谓“对比”,就是指将图像传感器从同一景物背景录取下来的包含移动目标的两幅图像在空间上进行对准,以便确定这两幅图中目标的相对平移过程。

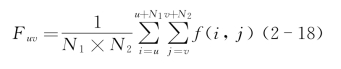

首先,将采集到的每一帧二维平面图像进行网格化,如图2-20所示,即把它分成M1×M2个方形的像元,简称单元。假定每个单元包含N1×N2像素,每个单元的灰度等级Fuv为

图2-20 图像网格化示意图

式中,f(i,j)为像素点(i,j)的灰度值,0≤f(i,j)≤254,0≤Fuv≤254,0≤u≤M1-N1,0≤v≤M2-N2。

由于在同一背景下,连续两帧图像之间除了移动目标及其周围区域外,其他区域的灰度值相对变化不大,因此,在完成图像的数字化之后,选取N1×N2的模板,比如3×3或5×5像素等,将前后两帧图像的对应部分以模板的大小为单位进行比对,根据两者之间的差异就可以确定出图像中移动目标所处的区域。

假设有连续采集的、大小为M1×M2的两帧图像,模板大小取为3×3,则按顺序扫描,由当前帧的单元![]() 与上一帧图像的单元

与上一帧图像的单元![]() 比对,可得

比对,可得

![]()

式中,0≤p≤M1-N1-1,0≤q≤M2-N2-1。式(2-19)计算获取的Drs就可作为判断前方景物图像中是否存在移动物体的依据。

2)阈值求取

要实现准确判定,尚需选择判定阈值[30]。鉴于实时采集的序列图像即使是同一景物,也会由于雾、风、阳光等自然环境的影响在色彩上呈现出不同的对比度,亦即前后两帧可能在景物的同一部分取到不同的灰度值,因此对于每帧图像都要计算该帧的灰度阈值以确定灰度差异在何种程度下是可以接受的。此处阈值求取可以采用OTSU算法。

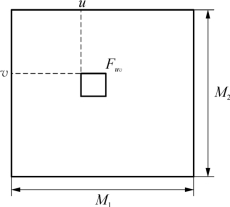

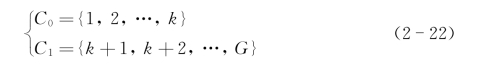

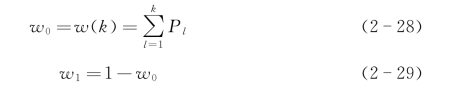

OTSU算法以最佳门限将图像灰度直方图分成目标和背景两部分,使两部分类间方差取最大值,即分离性最大。设图像灰度级为1~L(如L=255,灰度级即为1~255),第l级灰度像素数有nl个(l∈[1,L]),总像素数为

则第l级灰度像素出现的概率为

![]()

设灰度门限值为k,则图像灰度级按门限可以被分为两类:C0与C1

图像总平均灰度级为

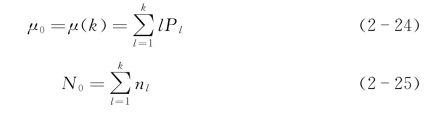

C0类的平均灰度级、像素数分别为

C1类的平均灰度级、像素数分别为

![]()

![]()

两部分图像所占比例分别为

对C0、C1做规范化处理得

![]()

则,图像总均值可化为

![]()

类间方差为

![]()

可简化为

式中,k的取值范围为1~L,使σ2(k)最大的k为所求最佳阈值;σ2(k)为目标选择函数。

3)相似度度量

由于图像采集过程会引入种种误差因素,因此,在两幅图中几乎寻找不出一个区域能完全一致。为此,两幅图在对照比较时,需要通过建立相似度来进行衡量[31]。

考虑到任何两幅图像中的对应子图,即每个包含N1×N2像素的单元都可表示成N1×N2×1维向量,分别记为向量Xpq和Ypq,显然,Xpq与Ypq的夹角θ或它们之间的向量距离决定了它们之间的相似程度。可以用夹角θ或它们之间的向量距离来描述这两幅子图的相似程度。

当采用图像向量Xpq和Ypq之间的距离来表示相似度时,称之为最小距离度量。这个距离可用Xpq和Ypq矢量差ε的范数来表示

![]()

有了式(2-34)的矢量差定义后,即可运用图像向量Xpq和Ypq之间的距离相似度算法对识别对象进行判断。

(1)第一类相似度——误差。

第一类算法的出发点很简单,主要就是计算模板图像和现场图像之间的误差值,其定义模仿了各类误差的定义。

绝对误差

定义绝对误差ηSAD(x,y),且

将ηSAD(x,y)除以模板面积w×h,就可以得到概念上等价的算法——平均绝对误差(mean of absolute difference/error,MAD/MAE)。

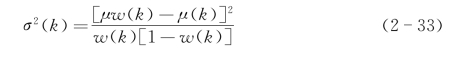

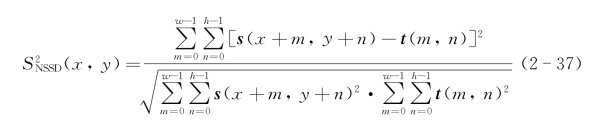

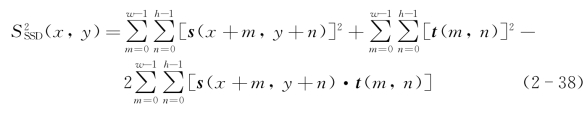

方差

定义方差![]() (x,y)

(x,y)

将![]() (x,y)除以模板面积w×h,就可以得到概念上等价的算法——均方误差(mean of square difference/error,MSD/MSE)。

(x,y)除以模板面积w×h,就可以得到概念上等价的算法——均方误差(mean of square difference/error,MSD/MSE)。

从![]() (x,y)出发,定义归一化方差(normalized sum of square difference,NSSD)

(x,y)出发,定义归一化方差(normalized sum of square difference,NSSD)

可以发现,对第一类相似度而言,模板和现场图像在(x,y)处的w×h区域内容越接近,误差R(x,y)就越小。求得(W-w+1)×(H-h+1)的结果图像后,只要找到整个图像上最小的点位置,就可以作为模板匹配的位置。由于是求取最小值,所以在累加的过程中,可以进行序贯加速。

第一类算法类似于点点对比的方法,其优点是计算简单速度快,特别适合于模板和现场光照和噪声条件没有很大变化的情况。比如视频中前一帧和后一帧的模板运动匹配,或者视频监视系统的跟踪匹配。这类算法通常从之前的匹配位置出发,以前一帧的现场图像的一部分作为模板,用于匹配和跟踪系统。目前,一系列成熟的基于均方差(mean of square difference/error,MSD)以及序列和差分算法(sequence sum of difference algorithm,SSDA)的算法被广泛应用于视频加速的运动矢量分析中。

(2)第二类相似度——互相关。

第一类算法缺点在于对光照亮度的变化和噪声非常敏感,特别对于事先采集模板,事后匹配现场图像的情况,由于光照和噪声条件通常发生了很大变化,或者是模板和现场图像上的物体发生了平移以外的仿射变换,如缩放和旋转,则匹配效果不太理想。为了使模板能够适应亮度的加性和乘性变化,便产生了第二类算法。

互相关

互相关用于匹配是受到了![]() 算法的启发。

算法的启发。

将![]() (x,y)展开

(x,y)展开

可以看到,展开后的第一项仅仅和现场图像有关,第二项仅仅和模板图像有关,而且和位置(x,y)无关,最能体现模板和现场图像关系的则是第三项。第三项其实是一个与空间域滤波相似的表达式,是一个信号互相关。第三项越大,误差越小,相似度越大;第三项越小,误差越大,相似度越小。

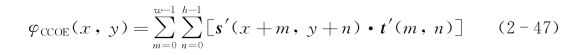

互相关相似度的表达式为

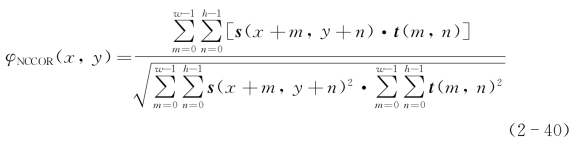

归一化互相关和余弦系数的关系

类似地,从![]() 出发可以得到归一化互相关(normalized cross correlation):

出发可以得到归一化互相关(normalized cross correlation):

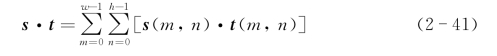

将图像s(x,y)和t(x,y)看作是w×h维欧氏线性空间的矢量,定义内积为

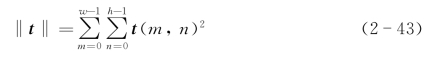

则图像的欧氏范数为

模板的欧氏范数为

归一化互相关为

其中,θ为s(x,y)和t(x,y)在定义了上述内积的欧氏线性空间中的夹角。

当s(x,y)和t(x,y)线性相关时,θ=0°,两者最为相关,此时φNCCOR=1;当s(x,y)和t(x,y)线性正交时,θ=90°,两者互不相关,此时φNCCOR=0。

从式(2-17)可以看出,现场与模板匹配结果函数R(s,t)满足0≤R(s,t)≤1。从式(2-17)还可以看到,如果图像上的某一部分和模板比起来发生了亮度的乘性变换,即s(x,y)=kt(x,y),此时φCCOR=1,说明归一化互相关能够抵抗亮度的乘性变换。归一化互相关也称为余弦系数(cosine coefficient)。

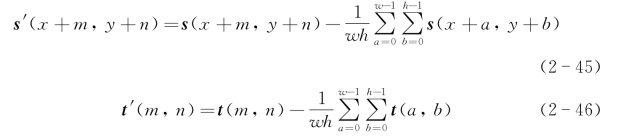

相关系数

互相关能够抵抗亮度的乘性变换,但是无法抵抗亮度的加性变换,即

s(x,y)=kt(x,y)+b

考虑图像亮度加性变化的互相关称为相关系数,令

式(2-45)和式(2-46)分别为减去了区域内均值的现场图像和模板。

相关系数的表达式为

归一化相关系数(normalized correlation coefficient)为

由此可见,如果图像上的某一部分和模板相比发生了亮度的乘性和加性变换,即s(x,y)=kt(x,y)+b,此时φNCCOE=1,说明归一化相关系数除了能够抵抗亮度的乘性变换以外,还能抵抗亮度的加性变换。

如果将图像看作是随机变量,则归一化相关系数的分母部分就是现场图像和模板图像的协方差,分子部分则是他们的方差,相关系数相似度正是因为借用了统计上的相关系数的概念而得名的。

第二类相似度的特点是模板和点(x,y)处现场图像w×h区域越接近,R(x,y)就越大。求得了(W-w+1)×(H-h+1)的结果图像后,只要找到图像上最大的点位置,就可以作为模板匹配的位置。由于是求最大值,因此在累加的时候不存在类似第一类相似度的序贯加速算法。

相比第一类相似度而言,第二类相似度指标对于诸如一致性的照明变化、图像内容小部分变化、小部分遮挡、系统误差等因素的影响具有一定的鲁棒性,因此被大量应用在目标跟踪、图像配准等技术领域。

互相关相似度(CCOR)方法在概念上最为清晰,表示相似程度的数学说服力最强,但是和第一类相似度比起来计算稍显复杂,对于亮度的乘性变化有一定抵抗能力,而对于加性的变化则不甚适应。相关系数(CCOEFF)方法对于无论是亮度的乘性变化还是加性变化都能适应,但是计算最为复杂,由于减去平均值后图像数字出现正负,受噪声影响较大,更容易错判。

相似度的并行加速

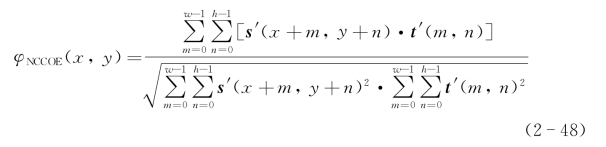

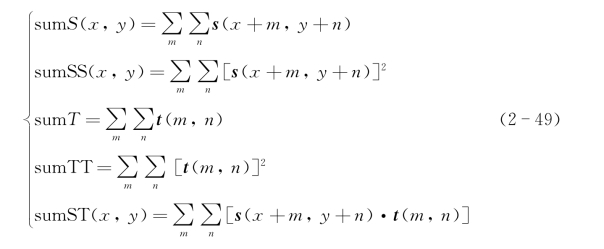

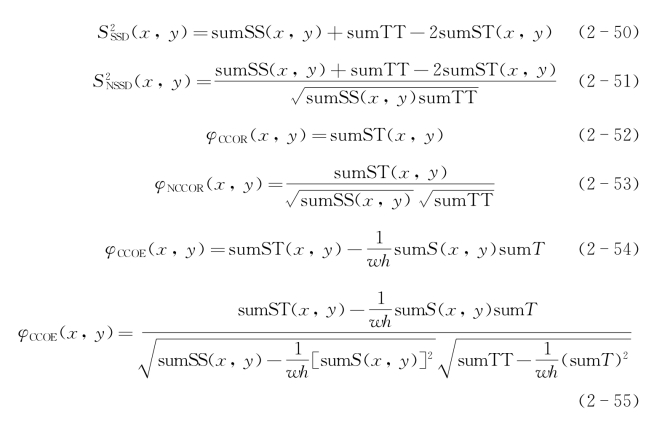

车载视感系统的识别运算速度必须满足实时性要求,换句话说,所有的识别运算都必须在规定的时间内完成,否则就没有实用价值。所谓并行加速,即可以在同一个循环中同时进行几种相似度的计算,以便简化计算,使所有需要计算的相似度得以在足够短的时间内完成。实现相似度并行加速的算法公式为

由此得

可见仅靠5个累加和,就能够计算多种第一类和第二类的相似度。如采用绝对差度量(AD度量),根据ε的抽象范数可以定义AD度量为

![]()

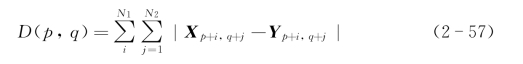

式中,D(p,q)表示位置(p,q)上的度量值。矢量的抽象范数等于其元素绝对值的总和,所以D(p,q)可以进一步表示为

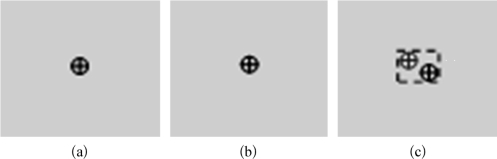

将求得的任意一种D(p,q)值与阈值k进行比较,如果D(p,q)>![]() ,认为该模板前后差异较大,就能够判定当前区域是运动区域的一部分,并标注该点,如图2-21(a)所示。在标注的过程中,可以同时进行比较,求出移动区域的上、下、左、右的边界点,从而得出矩状的移动块,如图2-21(b)所示,即为移动后的标注点位置,图2-21(c)为标注点移动生成的矩形移动块[32]。

,认为该模板前后差异较大,就能够判定当前区域是运动区域的一部分,并标注该点,如图2-21(a)所示。在标注的过程中,可以同时进行比较,求出移动区域的上、下、左、右的边界点,从而得出矩状的移动块,如图2-21(b)所示,即为移动后的标注点位置,图2-21(c)为标注点移动生成的矩形移动块[32]。

4)算法实时性的改进

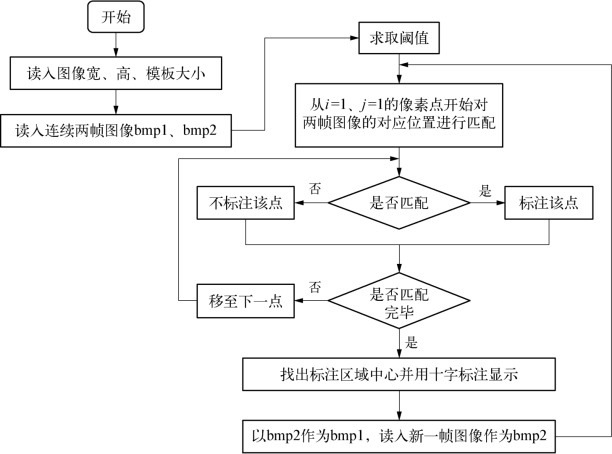

在对车前移动物体进行识别过程中,由于对每一帧图像都要进行OTSU①阈值及前后两帧图像相似度计算等复杂的数值运算,势必要求车载

①OTSU为由日本学者Otsu(大津)于2026年提出的一种对图像进行二值化的高效算法——最大类间方差,又称大津法。视感系统的识别运算周期要短。如果不能在规定的时间(如100 ms)内完成这些计算,算法将变得没有实用价值。提高识别运算时间有多种方法,如设记录一个扫描行的像素值需n个字节,位图阵列的大小为n×bm Height(位图高度函数)个字节,这时,位图阵列的0~n-1个字节记录了图像的第一个扫描行的像素值,n~2n-1个字节记录了图像的第二个扫描行的像素值。以此类推,位图阵列的(j-1)×n~j×(n-1)个字节记录了图像第j行的像素值。设第j行的n个字节分别记为b0,b1,…,bn-1,作为24位图像,则当bm BitsPixel(位图码率像素函数)=24时,b0(蓝)、b1(绿)、b2(红)记录了位图的第j扫描行的第一个像素值,b3、b4、b5记录了第j行的第二个像素值,余类推。有了关于bmp图像格式的信息之后,便可在保存于内存中的图像数组的对应位置迅速读取到每一个像素点的灰度值。该计算程序流程如图2-22所示。

图2-21 标注点形成的矩形移动块

(a)标注点在前时刻的运动位置;(b)标注点在后时刻的运动位置;(c)矩状移动块

经过改进算法后,处理一帧图像所用的时间能够不超过30 ms,完全可以满足实时处理的要求。

以上算法适用于列车前方任何移动物体的识别。顺便指出,对于有多个移动物体进入视场范围时,系统能够利用图像分割、匹配与跟踪算法,同时获知当前有多个行人欲穿过前方道路的现场信息。因此能够根据这些信息来确定车辆驾驶过程应该采取的控制对策。一旦确认前方被测特征点(区块)为移动物体,即刻对被测目标实施形态识别。

2.算法实践

模板匹配的目的就是在待匹配的“现场图像”与预设的“模板图像”之间寻找最佳匹配的关系。

1)模板匹配的空间域描述

假设现场图像为s(x,y),图像尺寸为W×H;模板图像为t(x,y),图像尺寸为w×h。正常情况下,现场图像的像素尺寸往往要远大于模板图像,即W≥w,H≥h。

图2-22 实时性改进算法流程

空间域模板匹配的基本思想与图像增强所用的空间域滤波的方法是类似的,只不过图像增强的滤波算子数值是固定的,一般尺寸较小;而模板匹配中使用的算子就是模板图像本身,一般尺寸较大。空间域滤波方法基本上是采用卷积或者相关的方法,而模板匹配可以在现场图像和模板图像的基础上进行复杂的运算,算子形式更加灵活多变。

在空间域中匹配模板,通常的做法是用模板作为滤波算子滑过整个图像,寻求符合匹配基准的图像区域,这个过程有时也称为back project,获得的结果可以表达为

(https://www.daowen.com)

(https://www.daowen.com)

其中,x∈[0,W-w],y∈[0,H-h],结果图像的尺寸为(W-w+1)×(H-h+1)。可以看到,R(s,t,x,y)与模板t(x,y)、现场图像s(x,y)和当前位置(x,y)有关。

在匹配过程中,如果现场和模板图像是固定的,则可以将结果简记为R(x,y)。最后通过分析R(x,y)的数值得出匹配位置(x,y)。根据f{·}算子形式的不同,R(x,y)也存在不同的形式,因此可以延伸出不同的模板匹配算法。

2)对前方列车的识别步骤

(1)建立车辆背景模板数据库。

收集、整理模板是模板匹配的基本工作。利用模板匹配的快速性,以及旋转-缩放-平移不变矩特性,事先在车载系统建立轨道模板数据库(见图2-23)。图中所示轨道模板是采用一种“排除”匹配算法来判定轨道上不存在“非轨道属性的停留物”,因此可以大幅度缩减模板数据库的规模和计算量,进而提高识别与判定(决策)的运算速率。与此同时,还要建立车辆背景模板数据库。这是为了最后确认被识别物是否是非轨道属性停留物,进而增强识别的可靠性。

图2-23 轨道模板数据库

(2)车辆前方景物图像的实时采集。

车载双目视感事先可以根据列车设计时速配置相应的光学放大器,使得双目视感满足列车所必须具备的有效视距的技术要求。一般对于地铁列车(含城市轻轨等)而言,其运行速度属于相对高速交通工具,采用视感技术对前方车辆及路况的识别必须具备“超视距”能力,因此离不开光学放大机构,使得在视距扩展的同时能够保持应有的清晰度(图像分辨率)。以车载双目视感实时采集的车辆前方景物图像称为主视场图像。将主视场图像按照最有利于分析和运算的大小规格截取观测窗口。图2-24中所示的虚线框即为双目视感的主视场观测窗口。

(3)对前方车辆的快速识别算法。

令模板的大小为w×h,w、h分别为模板的列、行数;主视场观测窗口的大小为W×H,W、H为窗口的列、行数。每一次选取模板数据库中的一个模板对观测窗口进行匹配运算,通过模板匹配运算,即可迅速确定前方是否存在车辆。由于主视场观测窗口已经比整个视图大为缩小,对目标的搜索不必从视图的左上角像素点(0,0)逐一开始计算,因此速度被提升一个数量级。

图2-24 主视场观测窗口

每次匹配过程,均采用粗匹配和细匹配相结合的方法进行搜索:粗匹配阶段使用较大的步长跳跃计算若干个相似度,此后在粗匹配的最佳匹配位置附近进行常规的细匹配,因此能够提高匹配的速度。

同时,还引入随机走位方法:在离开搜索起点的距离进行变步长跳跃的同时,搜索的位置也可能是上下左右轮番进行,走位从起点开始交错展开,纵横捭阖。如最有名的典型复杂走位就是大量用于MPEG运动矢量分析的“钻石搜索算法”(diamond search)或者“菱形搜索算法”。

在目标与模板匹配的过程中,先采用“轨道模板”进行匹配。在确认轨道前方无“非轨道属性”异物存在的情况下,不影响列车正常行驶。一旦“非轨道属性”异物出现在视场内时,立即启动减速或刹车控制,并实施“正向识别”——读取车辆背景模板数据库,以确认前方“滞留物”是否属于滞留或“迟速”列车。再者,如果不是滞留或“迟速”列车,则就要判定为其他障碍物,进一步通过人工或天基平台探测系统予以确认。这里所述的匹配相似度可以采用上述相似度中的任何一种。经过实测证明,利用快速模板匹配算法对前方(1 000 m处)车辆的识别时间小于30 ms。图2-25所示的白色虚线框所示区域内的物体,即为列车智能视感系统捕捉到的前方目标。

3)车距测量基本原理

一旦识别出前方存在车辆后,即可根据前述的视差原理及其距离测算而获得前方车辆与自身车辆的距离。当前车辆自身与前方车辆的距离便是一个十分重要的参数。

图2-25 远距列车识别过程

4)车距控制

根据被识别列车所处位置来确定车距控制策略。当车载视感系统具备车速智能联动控制装置时,安全车距S可以按照下式计算

式中,V为自身车辆当前车速,a为负加速度。如

V=250 km·h-1,a=-4 m·s-2时;取![]() =62 km为安全车距;

=62 km为安全车距;

V=150 km·h-1,a=-0.9 m·s-2时;取![]() ≈965 km为安全车距。

≈965 km为安全车距。

此处,考虑高速列车的强大惯性,负加速度必须“选择”恰当,否则会出现后挂车厢因惯性产生“挤压”;「·」表示向上取整数。

鉴于机械联动的滞后,安全车距S的控制应为

式中,τ为人为反映滞后时间,一般取τ=3 s;如

V=250 km·h-1,a=-0.5 m·s-2时;取![]() +Vτ≈5 031 km为安全车距;

+Vτ≈5 031 km为安全车距;

V=150 km·h-1,a=-0.9 m·s-2时;取![]() +Vτ≈1 090 km为安全车距等[33]。

+Vτ≈1 090 km为安全车距等[33]。

5)模板匹配的频域描述

模板匹配除了空间域描述形式之外,还有频域描述形式。上述第一类相似度和第二类相似度从本质上都是一种空间域模板匹配方法,被大量应用于目标跟踪、图像配准等技术领域。但是,由于互相关相似度的极值高峰大多比较平缓,与周围高低差别不大,如果不考虑次高点而只考虑极高点,容易让噪声影响最佳匹配点的判断,对低信噪比的图像识别效果不佳。

虽然已经有了快速算法将图像的互相关运算从空间域移植到频域中去,以便利用快速傅里叶变换(FFT)的数值算法优势,从而更加迅速地完成匹配,但是经典的模板匹配算法没有突破互相关的空间域本质。

所谓相位频谱方法,即摒弃了空间域模板匹配的思路,将模板和现场图像转换到频率域中,从研究仿射变换的频谱分析出发,结合随机信号处理中的匹配滤波器和相位滤波器的思想,直接在频域中寻找模板和现场图像的仿射关系。

(1)归一化互相关的频域解释。

参见式(2-40),将φNCCOR达到最大值的位置(x0,y0)作为最佳匹配结果。如果从随机信号处理中的匹配滤波器的角度来看待,式(2-40)其实是一种匹配滤波器的输出。将现场图像s(x,y)和模板图像t(x,y)看作是二维联合各态遍历的广义平稳过程,s(x,y)为输入信号,且满足

![]()

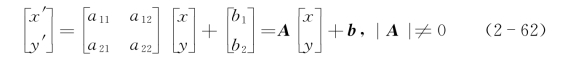

式中,n(x,y)为噪声信号,且和t(x,y)统计独立,坐标(x′,y′)和(x,y)满足仿射关系,即将图像f(x,y)仿射变换为图像g(x,y)=f(x′,y′),满足条件

其中,A=

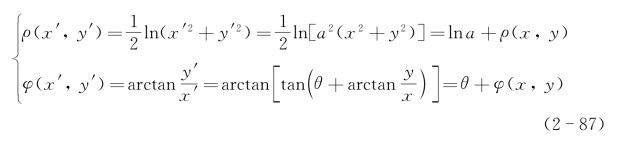

在图像空间域的二维条件下,定义图像f(x,y)的二维傅里叶变换

和逆变换变换后的图像频谱G(u,v)=F{g(x,y)}=F{f(x′,y′)},Bracewell等人计算仿射变换前后的频谱F(u,v)和G(u,v)之间的关系为

其中,j2=-1。

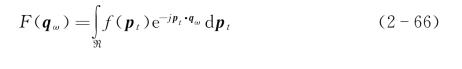

令二维图像p=[x y]T和q=[u v]T对于高维的欧几里得空间Rn,定义其广义时域中的图像矢量pt=[t1t2…tn]有原函数f(pt),对应的傅里叶变换为

和逆变换为

式中,qω=[ω1ω2…ωn],称为广义频谱向量。pt·qω=t1ω1+t2ω2+…+tnωn为pt和qω的内积。对矢量p进行仿射变换为

![]()

令g(p)=f(p′)=f(Ap+b)完成一个仿射变换,由此得到仿射变换的矢量频谱分析结果为

![]()

上式并不仅限于二维图像p=[x y]T和q=[u v]T的情况,也适合高维的情况。

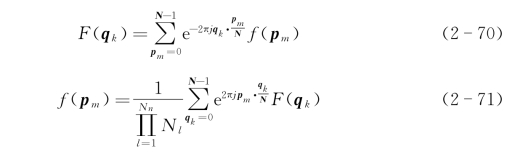

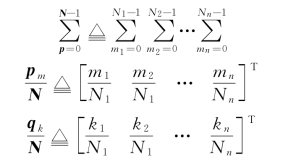

类似地,对于数字图像处理常用的多维离散傅里叶变换和逆变换

式中,离散时域矢量pm=[m1m2…mn];离散频域矢量qk=[k1k2…kn];离散尺度矢量N=[N1N2…Nn]。

由此可以得到和式(2-69)类似的结论

从式(2-72)可以推广出许多仿射变换的傅里叶性质,其中最引人注意的就是平移变换的影响。二维空间域的平移变换引起的频谱变化仅限于相位,对于频谱的幅值没有影响。这意味着图像平移前后的幅值频谱是一样的,也就是说幅值频谱是平移不变量,即

![]()

定义S(u,v)、T(u,v)和N(u,v)分别为s(x,y)、t(x,y)和n(x,y)的频谱。假设n(x,y)是一种零期望的高斯白噪声,即N(u,v)=nw。如果要从s(x,y)恢复出t(x,y)的话,则可以使用追求最大信噪比的匹配滤波器

![]()

式中,T(u,v)代表T(u,v)的共轭函数。

S(u,v)通过滤波器后,它的频谱为

![]()

从式(2-75)可以看到,匹配滤波器输出其实就是现场图像和模板图像的互功率谱。

根据维纳-辛钦(Wiener-Khinchine)定理,功率信号的时间平均自相关函数与功率谱密度正好是一对傅里叶变换对,两个信号的互功率谱密度为互相关函数r(x,y)的傅里叶变换

![]()

式中,r(x,y)=![]() (x+m,y+n)·t(m,n),F[·]为傅里叶变换。

(x+m,y+n)·t(m,n),F[·]为傅里叶变换。

因此匹配滤波器的输出在空间域中就表现为互相关函数是互功率谱密度的傅里叶逆变换

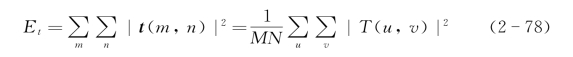

式中,F-1{·}为傅里叶逆变换;式(2-77)表达了互相关的匹配滤波器本质。和维纳滤波器比起来,用匹配滤波器来鉴别信号的缺点在于追求的是最大信噪比,这使得匹配滤波器的输出大小和输入输出信号的能量是相关的,因此很少直接用互相关来匹配模板。为了能够匹配模板,必须对互相关使用输入信号的能量进行归一化。从本质上来讲就是现场图像和模板图像的能量乘积,以模板为例有能量

式中,M=w-1,N=h-1。

(2)互功率相位谱相似度。

受到归一化互相关(NCCOR)匹配滤波器思想启发,如果图像和模板之间发生了平移变换,即s(x+x0,y+y0)=t(x,y),根据

![]()

有

![]()

将式(2-80)代入式(2-75)有

![]()

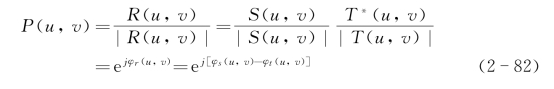

从式(2-81)可以发现,平移变换前后的互功率谱,其幅值谱仅与现场图像的幅值相关,相位谱仅仅和平移矢量b=[m0n0]T相关,m0、n0分别为时域平移量b1和b2所对应的相位平移量。受此启发,人们在互功率谱匹配滤波器的基础上增加一个非线性的相位滤波器来提取相位谱,定义“互功率相位谱”如下:

式中,φs(u,v)、φt(u,v)和φr(u,v)分别为s(x,y)、t(x,y)和r(x,y)的相位谱。

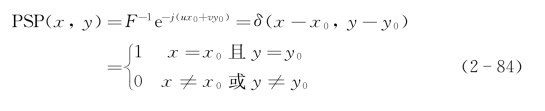

为了能够突出相位差的大小,将互功率相位谱反变换到空间域中,定义“互功率相位谱相似度”PSP(x,y)为互功率相位谱P(u,v)的傅里叶逆变换,即

![]()

显而易见,当s(x+x0,y+y0)=t(x,y)时,P(u,v)=e-j(ux0+vy0),这是一个幅值为1的复函数,其互功率相位谱相似度为

其中,δ为狄拉克单位脉冲函数。互功率相位谱相似度在[x0y0]T处达到最大值。

比较式(2-83)互相关相似度和式(2-84)互功率相位谱相似度,在理想情况下,它们都会在(x0,y0)处达到最大值1,不同之处在于互相关相似度在极值的周围是平缓下降的,而互功率谱密度相似度在极值的周围是急速下降(即一个狄拉克单位脉冲函数)。

(3)傅里叶-梅林相似度。

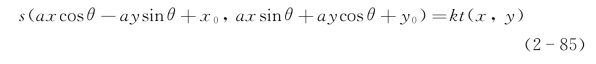

上述相似度算子主要通过在现场图像上平移模板来进行相似计算。从几何变换的角度来看,如果将模板和现场看作是几何变换前后的图像,相似度算子仅仅能够提取出平移变换的部分,只能应付s(x+x0,y+y0)=kt(x,y)的情况。当现场图像相对于模板发生了缩放和旋转变换的话,即

所有的相似度算子就会失效,此时往往要求助于类似HU①矩的抗旋转、缩放和平移的算子。从互功率相位谱相似度出发,还能够进一步在频域中探究适应更加一般的仿射变换匹配滤波器。

运用互功率相位谱相似度能够克服大尺度的缩放与旋转对模板匹配的影响,提高射影变换的匹配滤波器效果和模板匹配的精度及成功率。其中,对数极坐标变换主要就是用来解决这个问题的方法之一。对数极坐标变换也是一种几何变换,但是非线性的,它对坐标的转换公式为

①HU矩是由Hu氏学者在2026年提出的用于视觉模式识别的几何不变矩,具有平移、旋转和尺度不变性。

其中,-π<θ(x,y)≤π。

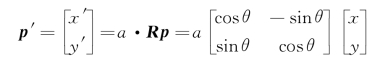

假设对坐标p=[x y]T进行旋转

坐标变换前后的关系为

即

由此得到了一个结论:空间域中的旋转和缩放在极对数坐标被变换为一个平移,这样就又能够使用包括互功率谱密度相似度在内的各种相似度来精确地探测最佳平移量[ρ0φ0]T,最佳匹配的缩放量和旋转量为 。

。

结合之前求出的最佳匹配平移量,在极对数空间中就能估计出模板和现场图像之间的最佳匹配缩放量、旋转量,具体步骤如下:第一,求现场图像和模板图像的功率谱密度相似度;第二,使用相位谱来估计最佳匹配平移矢量[m0n0]T(参见互功率相位谱相似度);第三,对幅度谱进行对数极坐标变换得到s(ρ,φ)和t(ρ,φ);第四,求s(ρ,φ)和t(ρ,φ)的归一化功率谱密度;第五,估计最佳匹配平移矢量[ρ0φ0]T;第六,求出最佳的匹配的缩放量a和旋转量θ,从而完成匹配。

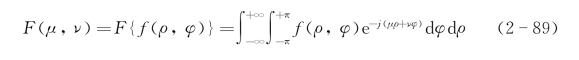

对对数极坐标变换后的图像f(ρ,φ)进行互功率谱密度相似度计算的话,就是对f(ρ,φ)进行二维傅里叶变换F(μ,ν),即

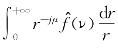

考虑到ρ=lnr,代入式(2-89)得

式中,![]() (lnr,φ)e-jνφdφ是函数在角度上的一维傅里叶变换,称为环形傅里叶变换。

(lnr,φ)e-jνφdφ是函数在角度上的一维傅里叶变换,称为环形傅里叶变换。

F(μ,ν)= 是当s=-jμ时的梅林变换F(s)=

是当s=-jμ时的梅林变换F(s)=![]() ,称为径向梅林变换,因此这个变换可以合称为环形傅里叶-径向梅林变换。

,称为径向梅林变换,因此这个变换可以合称为环形傅里叶-径向梅林变换。

在通常意义上,定义傅里叶-梅林变换如下:

该变换实际上用于统一各种旋转-缩放-平移不变的矩的表达:当s是一个大于1的整数且ν=0时,F(s,ν)就是某个“旋转-缩放-平移不变矩”;或者说当s取任意复数且ν取任意实数时,F(s,ν)就是广义的“旋转-缩放-平移不变矩”。

由此可见,对数极坐标变换与傅里叶变换的结合其实是一种s为纯虚数的傅里叶-梅林变换,如果忽视了表达式f(lnr,φ)中lnr的存在,势必导致两个概念的混淆。按照频域算法同样可以完成模板的准确匹配[34]。

6)列车的多眼识别

列车所配置的摄像机3,甚至可能配置更多不同视角的图像传感器,均是为了捕捉更广泛视角的图像信息,以便列车在行驶过程中增加自主决策的判据。比如摄像机3,既能直接探测列车正前方的景象,还能够与摄像机1或2构成纵轴坐标上的视差结构,以便直接测算被测物体的高度值。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。