图像标注技术为图像检索和文本检索搭起了一座桥梁,将图像映射为关键词,解决了图像难于被计算机检索的问题。基于此技术,用户可以将图像检索转化为关键词检索,非常符合人们的检索习惯。

应用机器学习的图像自动标注技术,在高层语义的标注上准确率较低,标注的深度不够,如通过现在最先进的图像识别算法,能识别出图像中的是一个人,却不能识别出那个人的名字(本书考虑的是互联网图像数据这一种海量数据的场景),不能很好地满足用户的需求。而利用图像周围文本分析的方法进行标注则受限于图像周围文本的丰富程度和文本质量,如用户发布了一张图片,但是却没有对图片进行任何文本描述,这会导致很多互联网图像因为周围文本信息不足,进而不能被系统检索到。为提高图像标注关键词的质量,本部分提出的标注模型充分利用了图像的各种多源信息,不仅仅只依赖图像周围文本信息,在更大的数据中分析出与它相似的图像,利用这些相似图像的标注词,学习到待标注图像的标注。

正是由于基于图像周围文本信息的标注方法,存在着文本缺失或文本信息不能描述图像的情况,因此在更大的数据集中寻找图像的相似图像,利用相似图像的标注对待标注图像进行标注显得很有必要。传统求解相似图像的方法是基于图像的视觉特征(颜色特征、纹理特征,形状特征),通过构建图像的视觉特征向量,利用欧式距离进行相似性的计算。这种基于图像本身信息相似性的求解方法,在视觉特征提取上存在着较大的时间开销,基于图像多源信息计算图像间的相似度不需要对图像的预处理步骤,而是直接对图像的相关信息进行分析。本书旨在利用图像的相关信息找到相似图像,利用其已有标签的图片对那些标签缺少或没有的图像进行标签补偿,进而完成无标签或少标签图像的标签补偿。

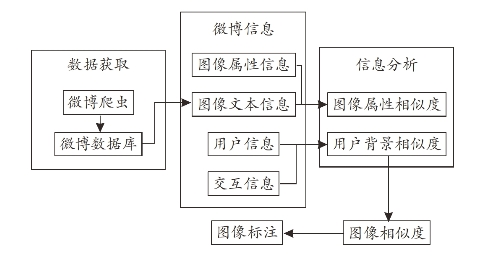

通过整合图像数据的诸多相关信息,分析图像,得到图像的相似图像的准确性将直接决定图像标签标注的最终效果,为了达到更好的相似图像求解,本书首先将数据预处理,使其数据结构化后作为图像自动标注模型的输入。通过收集整理互联网上不同来源的数据,根据图像数据不同维度的表示信息如图像的属性信息(图像发布时间、图像发布地点等)、图像文本信息、图像发布者信息、图像发布者的社交关系信息制订相应的相似度计算方法。通过图像的属性信息和图像文本信息计算图像相似度,利用图像发布者信息和图像发布者的社交信息计算图像发布者相似度,将图像相似度和图像发布者相似度经过拟合计算得到最后的图片相似度,通过相似图像的标签进行图像的标注,图像标注模型流程如图9-4所示。鉴于本书提出的基于多源大数据融合的图像标注模型对实验数据具有多源性质的要求,本书选择微博这一平台数据进行分析,具体的分析方法同样适用于其他多源数据分析。

图9-4 基于多源大数据融合的图像标注流程图

(一)数据预处理

在进行图像自动标注前,第一步是将输入数据处理为规范化、结构化的数据,根据数据的特点,需要指定相应的数据预处理方法。数据预处理包括数据除噪、中文分词、去停用词和数据规约。以下以微博数据为例进行简要介绍。

1.微博数据特点

对微博数据进行预处理之前,需要对微博数据的特点进行分析,根据其特点制订相应的预处理策略,通过爬虫采集到的微博数据。微博数据特点主要有以下三点。

第一,数据量巨大。微博用户每天都在不断地上传图片和发布推文,数据不断增长,规模巨大。

第二,文本化数据。推文都是文本化的数据。

第三,数据质量差异较大。由于微博用户发送微博,具有较大的主观性,导致信息存在缺少或者错误等质量问题。

2.微博数据预处理

本书采用爬虫获取大量的微博数据作为实验数据,本书主要获取微博用户发布图片的相关数据(图像、发布时间、发布地点、图片文字内容,获得赞数量、评论信息等)和用户信息(位置信息、标签信息、个人描述、社交信息)。选取了其中八大类——“旅游、时尚、娱乐、体育、军事、科技、美食、教育”数据,对其进除噪、分词、去停用词、入库处理,流程如图9-5所示。(www.daowen.com)

图9-5 数据预处理流程图

数据除噪:获取的微博数据中存在着诸多的噪音数据,噪音数据会影响后面的分析结果的准确性,因此第一步是去除噪音数据。去除噪音数据主要是去除微博内容中的特殊符号,如转发微博的表述符“@”,话题标识符“#”。例如。一条微博“放纵的自我就是无悔,#如果这就是人生#每天晚上九点准时相约”当中的“#”便需要过滤。在获取到的数据中还包含大量无图片的数据,本书旨在分析图片的相似性,利用相似图片进行图片的补充,因此过滤掉只有单一文字的微博。

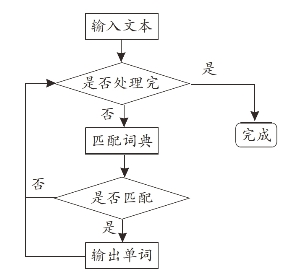

中文分词:计算机直接分析单词比分析文本更加容易,因此本书采用正向最大匹配算法,将图像的文本信息切分成独立的单词。该算法的思想是建立一个匹配词典,通过将待处理的文本与匹配词典中的词进行匹配,匹配成功则输出,直到所有文本检测完。其算法描述如图9-6所示。

图9-6 最大匹配中文分词算法流程图

去停用词:停用词是一些不能对信息分析提供信息量的词汇,在检索时同样不会涉及这些词汇,他们在信息分析中反而会降低分析算法的时间效率,因此在进行信息分析前需要去除停用词。推文中的停用词主要是中主要是助词、副词、连词等,如“的”“接着”“是”之类的。

数据规约:对于一张给定的微博图片i,其图片信息包含两种属性信息(图片相关信息、用户信息),因此i的模型表示可以分为2种属性信息表示问题,即Profile(i)={Image(i),User(i)},针对这两种属性的说明如下。

Image(i):微博图像包含了6种属性(微博文字内容、发布时间、发布地点、获得赞数量、评论数据、发布信息的设备类型数据)。由于微博评论数据往往是用户对图像发布者发布微博的看法,对图像的描述相对较少,并且评论数据繁多,质量不佳,不便于处理,因此微博评论数据不作为图像的属性值;发布信息的设备类型数据,对于图像内容的影响较小,不能作为图像的属性之一;获得赞数量表明了该微博的热度,对于微博图像没有说明作用,也不选取其作为属性之一。针对发布位置属性,在爬去到的数据中发现,发布位置存在着很大程度的缺少,针对缺少的值,采用用户从用户中的位置属性进行补全,考虑到用户也存在着一定的流动性,因此在补充的位置前赋予一个权重值w,最终选取微博文字内容、发布时间、发布地点三种作为微博图片的属性,即Image(i)={Tweet(i),Time(i),Location(i)}。

User(i):微博图像发布用户信息,用户信息包含四种属性信息(用户位置信息、标签信息、个人描述信息、社交信息)。用户的地理位置在很长一段时间具有稳定性,因此在微博地理信息缺少时,可以使用用户位置信息进行补全;标签信息则是对用户的一种分类,在某一领域的用户更多关注和发送自己领域的微博,如娱乐标签的用户大多数的微博是发送娱乐相关的微博图片;个人描述信息存在着较大的主观性,因此描述信息不作为用户的属性。关注用户信息中,能描画用户与其他用户相似性最有效的是相互关注的用户信息,因此相互关注用户信息将是对于交互信息的一个重要刻画。最终选取位置信息和标签信息作为用户的属性信息,即User(i)={Place(i),Tag(i),focusu(i)}。

经过数据除噪、中文分词、去停用词、数据规约后的微博图像信息和用户信息分别存入数据库。

(二)图像相似度分析

图像信息包括图像的属性信息(图像发布时间、发布地点、类别)和图像的文本描述。在实际的情况中,图像的文本描述存在着诸多的缺失,或与图像内容毫不相关的问题,只利用图像的文本描述计算图像的相似度,往往不能得到很好的结果,因此加上图像的属性信息,将使得图像相似度更加准确。下文将分别求解基于图像属性信息图像相似度和图像文本描述的相似度,通过加权运算将两者组合起来得到图像的相似度。其计算公式如下:

S(u,v)=w1SP(u,v)+w2ST(u,v)。其中,SP(u,u)表示基于属性的图像相似度,ST(u,v)为图像文本信息的相似度,w为权重,w1+w2=1。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。