NIPS 会议是20 世纪80 年代神经网络的孵化器,为其他可处理大型高维数据集的算法打开了大门。弗拉基米尔·瓦普尼克的支持向量机于1995 年引发了轰动,为20 世纪60 年代就被遗弃的感知器网络开辟了一个新篇章。使支持向量机成为功能强大的分类器,并出现在每个神经网络工作者工具包中的,是“内核技巧”(kernel trick),这是一种数学转换,相当于将数据从其采样空间重新映射到使其更容易被分离的超空间。托马索·波吉奥开发了一种名为“HMAX”的分级网络,可以对有限数量的对象进行分类。2这表明,网络的性能会随着其深度的增加而提高。

在21 世纪的头几年里,图形模型被开发出来,并与被称为“贝叶斯网络”(Bayes networks)的丰富的概率模型相结合,后者是基于18世纪英国数学家托马斯·贝叶斯(Thomas Bayes)提出的一个定理,该定理允许使用新的证据来更新先前的信念。加州大学洛杉矶分校的朱迪亚·珀尔,在早些时候曾将基于贝叶斯分析的“信念网络”(belief networks)3 引入人工智能,通过开发能够利用数据在网络中学习概率的方法,对贝叶斯分析进行了加强和扩展。这些网络以及其他网络的算法为机器学习研究人员打造出了强大的工具。

随着计算机的处理能力继续呈指数增长,训练更大规模的网络成为可能。大家曾普遍认为,具有更多隐藏单元、更宽的神经网络,比具有更多层数、更深的网络的效果更好,但是对于逐层训练的网络来说并非如此,4并且误差梯度的消失问题(the vanishing error gradient problem)被发现减慢了输入层附近的学习速度。5然而,当这个问题最终被克服的时候,我们已经可以对深度反向传播网络进行训练了,而且该网络在基准测试中表现得更好。6 随着深度反向传播网络开始在计算机视觉领域挑战传统方法,2012 年的NIPS大会上出现了这样一句话:“神经信息处理系统”里的“神经”又回来了。

在20 世纪的最后10 年以及21 世纪前10 年的计算机视觉领域,在识别图像中的对象方面取得的稳步进展,使得基准测试(用于比较不同方法)的性能每年能提高百分之零点几。方法改进的速度十分缓慢,这是因为每个新类别的对象,都需要有关专家对能够将它们与其他对象区分开来所需的与姿态无关的特征进行甄别。随后,在2012年,杰弗里·辛顿和他的两名学生艾力克斯·克里泽夫斯基(Alex Krizhevsky)和伊利娅·苏特斯科娃向NIPS会议提交了一篇论文,关于使用深度学习训练AlexNet 识别图像中的对象,AlexNet 是本章要重点讨论的深度卷积网络。7 以拥有22000 多个类别,超过1500 万个标记过的高分辨率图像的ImageNet 数据库作为基准,AlexNet史无前例地将识别错误率降低到了18%。8这次性能上的飞跃在计算机视觉社区中掀起了一股冲击波,加速推动了更大规模网络的发展,现在这些网络几乎已经达到了人类的水平。到2015 年,ImageNet 数据库的错误率已降至3.6%。9当时还在微软研究院的何恺明及其同事使用的低错误率深度学习网络,在许多方面都与视觉皮层十分相似;这类网络由杨立昆最早提出,并最初把它命名为“Le Net”。(www.daowen.com)

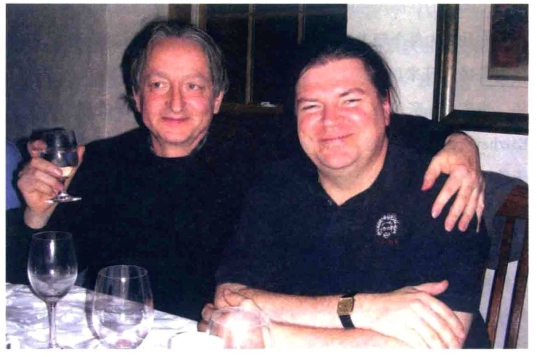

20 世纪80 年代,杰弗里·辛顿和我第一次见到这个法国学生杨立昆(见图9-1,右)。他9 岁时,就深受1968 年史诗级的科幻电影《2001太空漫游》(2001:A Space Odyssey)中的任务计算机HAL 9000的启发,想要开发人工智能。他曾独立发明了反向传播误差算法的一种版本,并记录在他1987 年的博士论文中,10 之后他就搬到多伦多,加入了杰弗里的团队。后来,他转去了美国电话电报公司(AT&T)在新泽西州霍姆德尔(Holmdel)的贝尔实验室,在那里他创造了一个可以读取信件上的手写邮政编码的网络,采用修订的美国国家标准与技术研究院(Modified National Institute of Standards and Technology,简称MNIST)数据库作为一种标记数据基准。每天有数百万封信件需要递送到信箱里;而今天,这个过程是完全自动化的。同样的技术也可以用来自动读取ATM 机上银行支票的金额。有趣的是,最难的部分其实是查找支票上数字的位置,因为每张支票都有不同的格式。早在20 世纪80 年代,杨立昆就显露出了证明原理(学者们擅长的事情)并将之应用在现实世界中的非凡天赋。后者要求实际产品必须经过严格的测试,且表现稳健。

图9-1 杰弗里·辛顿和杨立昆是深度学习领域的大师。这张照片是2000 年左右在加拿大高等研究院的神经计算和自适应感知项目会议上拍摄的,该项目是深度学习领域的孵化器。图片来源:杰弗里·辛顿。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。