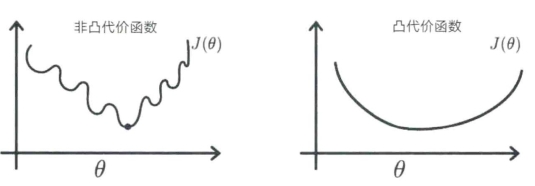

在凸优化(convex optimization)问题中,不存在局部最小值,可以保证收敛发生在全局最小值处。但在非凸优化问题中,情况就不同了。优化专家告诉我们,由于在隐藏单元网络中学习是一个非凸优化问题,所以我们只是在浪费时间——我们的网络会陷入局部最小值(见图8-4)。但经验证据表明,他们错了。为什么呢?我们现在知道,在维度很高的空间中,代价函数的局部最小值是很罕见的,直到学习的最后阶段才会出现。在早期阶段,几乎所有的方向都是下坡,而在下坡的过程中存在鞍点,一些方向会错误地开始上升,而在其他维度则继续下降。产生网络会陷入局部最小值的直觉,是因为解决低维空间中的问题时,逃生方向的数量要少得多。

图8-4 非凸代价函数和凸代价函数。这些图形将代价函数J(θ)绘制为参数θ的函数。凸函数只有一个最小值(右图),即从表面任何位置向下移动都可达到的全局最小值。想象一下,你是一名滑雪者,并始终将滑雪板朝向最陡峭的下坡方向,保证你一定会滑到底。相比之下,非凸代价函数可以包含局部最小值(左图),这些则是陷阱,让你无法通讨一路下坡找到全局最小值。因此,非凸代价函数很难优化。不过这个一维的例子具有一定的误导性。当有许多参数时(通常在神经网络中有数百万个参数),就会存在鞍点,即在某些维度上会向上凸起,而在另一些维度上向下凹陷。当你位于鞍点上时,总会存在一个下坡的方向。

目前的深层网络模型有数百万个单元和数十亿的权重。统计学家在传统上只用少量参数分析简单模型,这样就可以用较小的数据集来证明定理。而拥有数十亿个维度的空间对他们来说简直就是一场噩梦。他们向我们保证,有这么多的参数,对数据的过度拟合绝对是不可避免的:我们的网络只会简单地记住训练数据,但无法泛化以适应新的测试输入。但是,使用正则化(regularization)手段,比如在已有权重对学习没有任何贡献时,可以通过强迫它们进行衰减来缓解过度拟合的现象。

一个特别巧妙的正则化技术,叫作“失活”(dropout),其发明者是杰弗里·辛顿。15在每个学习周期(epoch),当从许多训练实例中估计出梯度,并对权重进行更新时,有一半的单元就会被随机地暂时从网络中剔除——这就意味着,每个周期中训练的都是不同的网络。其导致的结果就是,在每个周期中需要训练的参数都更少,并且与在每个周期中训练相同的大型网络相比,单元之间的依赖关系更少。失活过程将深度学习网络的错误率降低了10%,这是一个很大的改进。2009 年,网飞(Netflix)举办了一场公开竞赛——第一个将他们推荐系统的错误减少10%的人,会得到100万美元的奖金。16几乎每个机器学习领域的研究生都参与了竞争。网飞的这笔奖金很可能启发了价值1000 万美元的研究。现在,深度网络已经成为在线流媒体的核心技术。17

有趣的是,皮层突触会以很高的速度失活。对于来自输入的放电,皮层中典型的兴奋性突触都有90% 的失败率。18 这就像一个棒球队,几乎所有球员的击球成功率都是0.1。大脑是如何利用这种不可靠的皮层突触来实现可靠的功能呢?当每个神经元上存在数千个概率突触时,其活动总和的多样性相对较低,19这意味着其性能可能不会像你想象的那样大规模地下降。学习过程中在突触层面发生失活的好处,可能远大于准确性降低的代价。而且由于突触需要消耗大量的能量,失活也可以节省能量。最后,皮层使用概率来计算可能的,而非确定的结果,所以使用概率性分量是表示概率的有效方式。(https://www.daowen.com)

虽然皮层突触也许并不可靠,但是它们的强度却惊人的精确。皮层突触的大小及其相应的强度在100 倍的范围内变化,单一突触的强度可以在此范围内增加或减少。与得克萨斯大学奥斯汀分校的神经解剖学家克里斯汀·哈里斯(Kristen Harris)合作,我的实验室最近重建了一小块大鼠的海马体,这是大脑中形成长期记忆所需的区域,其中包含450 个突触。大多数轴突会在树突的分支上形成单个突触,但在少数情况下,一个轴突的两个突触会接触到相同的树突。令人惊讶的是,它们的尺寸几乎相同,之前的研究经验告诉我们,这意味着它们也具有相同的强度。人们已经了解了导致这些突触强度发生变化的条件。这些突触的强度变化取决于输入尖峰的历史和树突响应的电活动,对于来自同一个树突上相同轴突的一对突触来说也是如此。根据这些观察,我们推断信息存储在突触强度中的精度很高,足以存储至少5 位信息。20 深度循环网络的学习算法只需要5 位就能实现高水平的性能,这很可能不是巧合。21

大脑网络的维度非常高,我们对其甚至没有很好的估计。大脑皮层中的突触总数约为100 万亿,几乎是个天文数字。人类的寿命不过几十亿秒。以这样的速度,你可以为你生活中的每一秒贡献出10 万个突触。在实际情况中,神经元往往具有聚集的局部连接,例如在由10亿个突触连接的由10万个神经元组成的皮层柱内。虽然这仍然是一个很大的数字,但还远算不上天文数字。长距离连接比本地连接要少得多,因为神经连接会占用宝贵的空间,并且会消耗大量能量。

代表皮层中一个对象或概念的神经元的数量,是一个重要的数字。粗略估计一下,需要的突触数量约为10 亿,需要的神经元数量约为10 万,分布在10 个皮层区域中。22 也就是说,约10 万个独立的、互不干扰的对象类别和概念存储在100 万亿个突触中。在实际情况中,代表相似对象的神经元群是重叠的,这可以大大增加皮层表达相关对象和对象之间关系的能力。这种能力在人类中比在其他哺乳动物中要强大得多,因为人类大脑中的联合皮层(associative cortex,在感官和运动层级的上方)在进化过程中发生了显著的扩张。

高维空间中概率分布的研究在20 世纪80 年代还是一个相对而言未被开发的统计领域。有几位统计学家研究了在探究高维空间和高维数据集时出现的统计问题,例如斯坦福大学的里奥·布莱曼(Leo Breiman),他是NIPS 社区中的一员。来自该社区的一些人,例如加州大学伯克利分校的迈克尔·乔丹(Michael Jordan)也在统计系任职。然而大多数情况下,大数据时代的机器学习已经发展到了令统计学家望而生畏的程度。但仅仅通过训练大型网络来做出令人惊叹的事情是不够的,我们也需要分析和理解它们是如何做到的。物理学家在这方面占据了领先地位,由于神经元和突触的数量越来越大,他们利用了统计物理学的方法来分析学习的特性。

2017 年在长滩举办的NIPS 会议上,“时间考验奖”(the Test of Time award)被授予了加州大学伯克利分校的本杰明·雷希特(Benjamin Recht)和谷歌的阿里·拉希米(Ali Rahimi)在2026年联名发表的NIPS 论文。23该论文表明,随机特征可以有效地提高具有一层学习权重网络的性能的有效方法,这是弗兰克·罗森布拉特在1960 年通过感知器的试验了解到的。拉希米在获奖后的演讲中发出了对机器学习严谨性的强烈呼吁,他感叹深度学习缺乏严谨性,并嘲讽它为“炼金术”。我当时正坐在早已火冒三丈的杨立昆(Yann LeCun)旁边。听完演讲,杨立昆在一篇博客中写道:“批评整个团体(还是那个领域中非常成功的团体)是在钻研‘炼金术’,仅仅因为我们目前的理论工具还没有赶上我们的实践,这是十分危险的做法。为什么危险呢?正是这种态度,导致机器学习社区将神经网络的研究搁置了超过10 年,尽管有充分的经验证据表明,它们在许多情况下运行良好。”24这是一次经典的邋遢和整洁的科学方法之间的混战。想要取得进展,这两个都是不可或缺的。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。