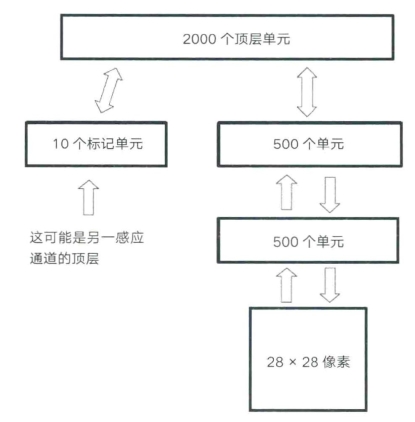

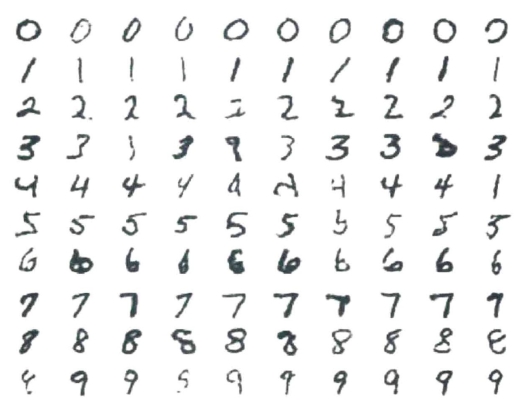

最近,杰弗里·辛顿和他在多伦多大学的学生们训练了一个带有三层隐藏单元的玻尔兹曼机,能够对手写邮政编码进行非常准确的分类(见图7-6)。20由于玻尔兹曼网络具有反馈和前馈连接,因此可以反向运行网络,钳制其中一个输出单元,并生成与钳制输出单元相对应的输入模式(见图7-7)。这种生成性网络能捕获训练集的统计结构,而它们生成的样本也会继承这些属性。就好像这些网络进入了睡眠状态,网络最高层的活动在输入层产生了梦境一般的状态序列。

图7-6 用于手写数字识别和生成样本的多层玻尔兹曼机。图像具有28×28 个像素,可以是白色或黑色。目标是根据10个输出单位(0-9)对数字进行分类。图片来源:G.E.Hinton,“Learning Multiple Layers of Representation,”Trends in Cognitive Sciences 11(2007):428-434.figure 1。(https://www.daowen.com)

图7-7 由经过训练后可以识别手写数字的多层玻尔兹曼机生成的输入层图案。每一行都是通过钳制10 个输出单元中的一个产生的(见图7-6),并且输入层在上述示例之间持续变化。这些数字都没有在训练集中出现过——它们是被训练有素的网络的内部结构“幻想”出来的。图片来源:G.E.Hinton,S.Osindero and Y.Teh,“A Deep Learning Algorithm for Deep Belief Nets”,Neural Computation 18(2006):1527-1554,figure 8。

尽管神经网络在物理学和工程学中的兴起十分迅速,但传统的认知科学家却迟迟不能接受它作为理解记忆和语言处理的形式体系。除了拉荷亚的并行分布处理(PDP)研究组和一些独立的研究者,符号处理仍然是业界的主流方法。杰弗里和我在1983 年参加了认知科学协会(Cognitive Science Society)的会议。会议期间,研究短期记忆和意象的心理学家泽农·派利夏恩(Zenon Pylyshyn)表示出了对玻尔兹曼机的不屑。他朝讲台上泼了一杯水,并大声喊道:“这不是计算!”而其他人则认为整个领域仅仅是在搞统计罢了。但杰罗姆·莱特文(Jerome Lettvin)却表示,他真的非常喜欢我们正在做的事情。莱特文在1959 年与温贝托·马托拉那(Humberto Matourana)、沃伦·麦卡洛克(Warren McCulloch)和沃尔特·匹茨(Walter Pitts)一起撰写了经典的论文《青蛙的眼睛告诉大脑什么》(What the Frog's Eye Tells the Frog's Brain)。21文中给出了青蛙视网膜中的虫类探测器神经元对小黑点的反应最为强烈的证据,这是一个在系统神经科学领域极具影响力的想法。他对我们羽翼未丰的神经网络模型的支持是该领域早期发展中的重要一环。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。