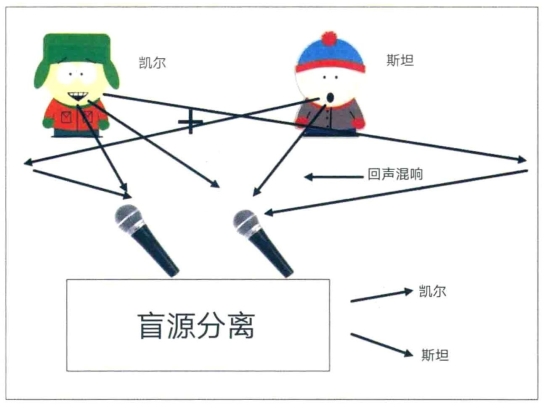

在一个拥挤的鸡尾酒会上,当空气中弥漫着其他人谈笑的嘈杂声时,想要听见你面前的人说话是很费劲儿的。你的两只耳朵有助于你把听力集中在正确的方向,而你的记忆可以填补没听清的谈话内容。现在想象一下,房间里正在举行一个有100 人参加的鸡尾酒派对,四周还有100 个以任意方向排布的麦克风。每个麦克风都会采集所有人的声音,但是每个麦克风针对每个人采集的声音振幅比不同。是否有可能设计出一种算法,将每种声音分离成单独的输出声道?或者更复杂点,如果声音来源是未知的,比如混合了音乐、拍手声、自然声音,甚至是随机的噪声呢?这就是所谓的“盲源分离问题”(见图6-1)。

1986 年4 月13—16 日,在犹他州雪鸟城举办的神经网络计算会议,也就是AIP 会议(NIPS 大会的前身)上,出现了一个题为《利用神经网络模型进行空间或时间自适应信号处理》(Space or Time Adaptive Signal Processing by Neural Network Models)的墙报。它的作者詹妮·埃罗(Jeanny Herault)和克里斯蒂安·于滕(Christian Jutten)使用了一种学习算法,对输入给神经网络模型的混合正弦波(均为纯频率)进行了盲分离,并指出了一类新的无监督学习算法。1 虽然当时还不知道是否存在一种可以盲分离其他类型信号的通用解决方案,但十年之后,安东尼·贝尔和我发现了一种可以解决一般问题的算法。2(https://www.daowen.com)

图6-1 盲源分离。凯尔和斯坦在有两个麦克风的房间里同时说话。每个麦克风会从扬声器以及房间墙壁反射的声音里采集信号。该实验的挑战就在于,如何在对信号的相关信息一无所知的情况下将两个声音彼此分开。独立分量分析是一种学习算法,可以在不了解信息源的情况下解决这个问题。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。