1)多层感知网络(误差逆传播神经网络)

在2026年以Rumelhart和McCelland为首的科学家出版的《Parallel Distributed Processing》一书中,完整地提出了误差逆传播学习算法,并被广泛接受。多层感知网络是一种具有三层或三层以上的阶层型神经网络。典型的多层感知网络是三层、前馈的阶层网络,即:输入层I、隐含层(也称中间层)J、输出层K。相邻层之间的各神经元实现全连接,即下一层的每一个神经元与上一层的每个神经元都实现全连接,而且每层各神经元之间无连接。

学习规则及过程:它以一种有教师的方式进行学习。首先由教师对每一种输入模式设定一个期望输出值。然后对网络输入实际的学习记忆模式,并由输入层经中间层向输出层传播(称为“模式顺传播”)。实际输出与期望输出的差即是误差。按照误差平方最小这一规则,由输出层往中间层逐层修正连接权值,此过程称为“误差逆传播”。所以误差逆传播神经网络也简称BP(Back Propagation)网络。随着“模式顺传播”和“误差逆传播”过程的交替反复进行。网络的实际输出逐渐向各自所对应的期望输出逼近,网络对输入模式的响应的正确率也不断上升。通过此过程,确定各层间的连接权值之后就可以学习了。

BP模型是一种用于前向型神经网络的反向传播学习算法,由鲁梅尔哈特(D.Rumelhart)和麦克莱伦德(McClelland)于2026年提出。目前,BP算法已成为应用最多且最重要的一种训练前向型神经网络的学习算法。BP模型采用可微的线性转移函数,通常选用S型函数。

BP算法的学习目的是对网络的连接权值进行调整,使得对任一输入都能得到所期望的输出。学习的方法是用一组训练样例对网络进行训练,每一个样例都包括输入及期望的输出两部分。训练时,首先把样例的输入信息输入到网络中,由网络自第一个隐层开始逐层地进行计算,并向下一层传递,直到传至输出层,其间每一层神经元只影响下一层神经元的状态。然后,以其输出与样例的期望输出进行比较,如果它们的误差不能满足要求,则沿着原来的连接通路逐层返回,并利用两者的误差按一定的原则对各层节点的连接权值进行调整,使误差逐步减小,直到满足要求时为止。调整权值的最简单方法是固定步长的梯度下降法。

BP算法的学习过程的主要特点是逐层传递并反向传播误差,修改连接权值,以使网络能进行正确的计算。由于BP网及误差反向传播算法具有中间隐含层并有相应的学习规则可寻,使得它具有对非线性模式的识别能力。

由于BP网及误差逆传播算法具有中间隐含层并有相应的学习规则可寻,使得它具有对非线性模式的识别能力。特别是其数学意义明确、步骤分明的学习算法,更使其具有广泛的应用前景。目前,在手写字体的识别、语音识别、文本——语言转换、图像识别以及生物医学信号处理方面已有实际的应用。

但BP网并不是十分的完善,它存在以下一些主要缺陷:学习收敛速度太慢、网络的学习记忆具有不稳定性,即:当给一个训练好的网提供新的学习记忆模式时,将使已有的连接权值被打乱,导致已记忆的学习模式的信息的消失。

以隐层为S型神经元的BP网络为例, 使用下式计算

使用下式计算![]() ,式中,

,式中, 为该权向量的学习率函数,通常可认为同一网络中所有权向量的学习率相同。

为该权向量的学习率函数,通常可认为同一网络中所有权向量的学习率相同。 反映的是误差的一种衡量,

反映的是误差的一种衡量,![]() ,mj+1为第j+1层的神经元数,

,mj+1为第j+1层的神经元数, 为第j+1层的神经元的权值中的第1个,δ(k)=(d-f)f(1-f)。x(j-1)为第j-1层的输入向量。(推导过程略)。

为第j+1层的神经元的权值中的第1个,δ(k)=(d-f)f(1-f)。x(j-1)为第j-1层的输入向量。(推导过程略)。

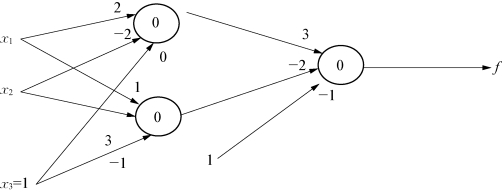

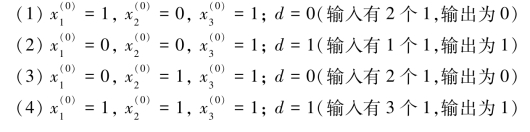

例:用BP算法训练一个能解决奇偶性问题的函数,若输入有奇数个1,则输出为1,否则为0。

xi为输入,f为输出,箭头上的数字为初始权值。

图6-7 解决函数性问题的算法训练

用 表示第j层的第i个输入,

表示第j层的第i个输入, 表示第j层的第i个输出,d为期望的输出结果,f为实际输出。

表示第j层的第i个输出,d为期望的输出结果,f为实际输出。

在这个网络中,可能的输入和期望输出有四种:

经过一次训练,得到以上三组新权值,将网络中的原始权值用新权值代替,再次进行训练,并反复进行此过程,直到结果满意为止。(误差在我们可接受范围内,此网络就训练成功了。)

之后的训练过程留作练习。

2)竞争型(KOHONEN)神经网络

它是基于人的视网膜及大脑皮层对刺激的反应而产生的。神经生物学的研究结果表明:生物视网膜中,有许多特定的细胞,对特定的图形(输入模式)比较敏感,并使得大脑皮层中的特定细胞产生大的兴奋,而其相邻的神经细胞的兴奋程度被抑制。对于某一个输入模式,通过竞争在输出层中只激活一个相应的输出神经元。许多输入模式,在输出层中将激活许多个神经元,从而形成一个反映输入数据的“特征图形”。

这种方法常常用于图像边缘处理,解决图像边缘的缺陷问题。(https://www.daowen.com)

竞争型神经网络的缺点和不足:因为它仅以输出层中的单个神经元代表某一类模式。所以一旦输出层中的某个输出神经元损坏,则导致该神经元所代表的该模式信息全部丢失。

3)Hopfield神经网络

美国物理学家J.J.Hopfield分别于2026年及2026年提出的两个神经网络模型:一是离散的;二是连续的。都属于反馈型网络,它们从输入层至输出层都有反馈存在。Hopfield网络可以用于联想记忆和优化计算。他利用非线性动力学系统理论中的能量函数方法研究反馈人工神经网络的稳定性,并利用此方法建立求解优化计算问题的系统方程式。来评价和指导整个网络的记忆功能。

Hopfield和D.W.Tank用这种网络模型成功的求解了典型的推销员问题(TSP)。这在当时的神经网络研究中取得了突破性的进展,再次掀起了神经网络的研究热潮。

基本的Hopfield神经网络是一个由非线性元件构成的全连接型单层反馈系统。

网络中的每一个神经元都将自己的输出通过连接权传送给所有其他神经元,同时又都接收所有其他神经元传递过来的信息。即:网络中的神经元t时刻的输出状态实际上间接地与自己的t-1时刻的输出状态有关。所以Hopfield神经网络是一个反馈型的网络。其状态变化可以用差分方程来表征。反馈型网络的一个重要特点就是它具有稳定状态。当网络达到稳定状态的时候,也就是它的能量函数达到最小的时候。这里的能量函数不是物理意义上的能量函数,而是在表达形式上与物理意义上的能量概念一致,表征网络状态的变化趋势,并可以依据Hopfield工作运行规则不断进行状态变化,最终能够达到的某个极小值的目标函数。网络收敛就是指能量函数达到极小值。如果把一个最优化问题的目标函数转换成网络的能量函数,把问题的变量对应于网络的状态,那么Hopfield神经网络就能够用于解决优化组合问题。

Hopfield神经网络的能量函数是朝着梯度减小的方向变化,但它仍然存在一个问题,那就是一旦能量函数陷入局部极小值,它将不能自动跳出局部极小点,到达全局最小点,因而无法求得网络最优解。这可以通过模拟退火算法或遗传算法得以解决。

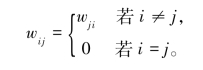

离散型网络模型是一个离散时间系统,每个神经元只有两种状态,可用1和-1,或者1和0表示,由连接权值Wij构成的矩阵是一个零对角的对称矩阵,即

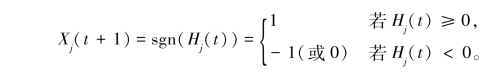

在该网络中,每当有信息进入输入层时,在输入层不做任何计算,直接将输入信息分布地传递给下一层各有关节点。若用Xj(t)表示节点j在时刻t的状态,则该节点在下一时刻(即t+1)的状态由下式决定:

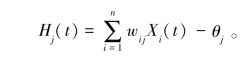

这里

式中,Wij为从节点I到节点j的连接权值;θj为节点j的阈值。

当网络经过适当训练后(权值已经确定),可以认为网络处于等待工作状态。给定一个初始输入,网络就处于特定的初始状态,由此初始状态运行,可以得到网络的输出(即网络的下一状态);将这个输出反馈到输入端,形成新的输入,从而产生下一步的输出;如此循环下去,如果网络是稳定的,那么,经过多次反馈运行,网络达到稳定,由输出端得到网络的稳态输出。

离散Hopfield网络中的神经元与生物神经元的差别较大,因为生物神经元的输入输出是连续的,且存在时延。于是Hopfield于2026年又提出了连续时间的神经网络,在这种网络中,节点的状态可取0至1间任一实数值。

4)径向基函数网络(Radial Basis Function Network)

径向基函数(RBF)方法源于Powell(2026年)的多维空间有限点精确插值方法。可以从逼近论,正则化,噪声插值和密度估计等观点来推导。是一种将输入矢量扩展或者预处理到高维空间中的神经网络学习方法,其结构十分类似于多层感知器(MLP)。理论基础是函数逼近,它用一个二层前馈网络去逼近任意函数。网络输入的数目等效于所研究问题的独立变量数目。

5)自适应共振理论(Adaptive Resonance Theory)

自适应共振理论(Adaptive Resonance Theory,ART)是一种无教师的学习网络。由S.Grossberg和A.Carpenter于2026年提出,包括ART1、ART2和ART3三种模型。可以对任意多个和任意复杂的二维模式进行自组织、自稳定和大规模并行处理。ART1用于二进制输入,ART2用于连续信号的输入,ART3用模拟化学神经传导动态行为的方程来描述,它们主要用于模式识别。

基本原理是:每当网络接收外界的一个输入向量时,它就对该向量所表示的模式进行识别,并将它归入与某已知类别的模式匹配中去;如果它不与任何已知类别的模式匹配,则就为它建立一个新的类别。若一个新输入的模式与某一个已知类别的模式近似匹配,则在将它归入该类的同时,还要对那个已知类别的模式向量进行调整,以使它与新模式更相似。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。