Spark 的安装需要依赖于Hadoop 集群和Scala 环境,这些已经在前面安装完成。

一、下载对应版本的Spark

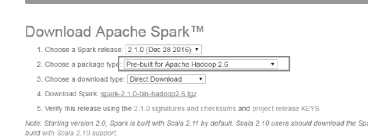

进入下载页面http://spark.apache.org/downloads.html,由于使用的Hadoop 版本是2.6.5,因此选择基于该版本的Spark2.1.0,如图8-5 所示:

图8-5 Spark 下载

二、解压spark-2.2.0-bin-hadoop2.6.tgz

将下载的spark-2.2.0-bin-hadoop2.6.tgz 解压到/hadoop 目录下

tar -xvf spark-2.1.0-bin-hadoop2.6.tgz -C /hadoop/

三、进入spark 的conf 目录

1.配置slaves 文件

(1)cp slaves.template slaves

(2)其内容改为

slave1

slave2

2.配置spark-env.sh 文件

(1)cp spark-env.sh.template spark-env.sh

(2)在文件末尾增加以下内容:

export JAVA_HOME=/Java/jdk1.8.0_144

export HADOOP_HOME=/hadoop/hadoop-2.6.5

export HADOOP_CONF_DIR=/hadoop/hadoop-2.6.5/etc/hadoop

export SCALA_HOME=/hadoop/scala-2.11.0/bin

export SPARK_MASTER_IP=master

export SPARK_WORKER_MEMORY=1g

四、将spark 文件分发到salve1 和slave2 节点

scp -r /hadoop/spark-2.1.0-bin-hadoop2.6/ slave1:/hadoop/

scp -r /hadoop/spark-2.1.0-bin-hadoop2.6/ slave2:/hadoop/

五、启动Spark 分布式集群并查看信息(www.daowen.com)

1.启动Hadoop 集群

2.启动Spark 集群

由于Spark 集群的启动脚本也为start-all.sh,所以需要到Spark 的sbin 目录下执行"./start-all/sh"。

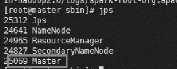

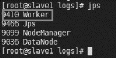

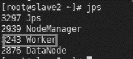

此时,在master 节点多一个Master 进程,salve1 和slave2 节点多一个worker 进程,如图8-6,8-7,8-8 所示:

图8-6 master jps 信息

图8-7 slave1 jps 信息

图8-8 slave2 jps 信息

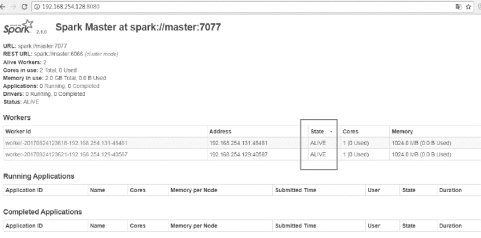

可以进入Spark 集群的Web 页面,访问http://192.168.254.128:8080/,如图8-9所示:

图8-9 Spark Web 信息

六、测试Spark 集群

向HDFS 上传Spark 安装包下的README.txt 文件:

hdfs dfs -put /hadoop/spark-2.1.0-bin-hadoop2.6/README.md /test

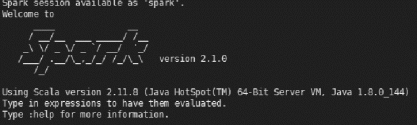

进入Spark 的bin 目录下,使用"./spark-shell --master spark://master:7077"命令启动Spark shell,出现如图8-10 的Spark 欢迎界面:

图8-10 Spark 启动界面

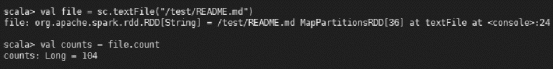

执行如下命令:

val file = sc.textFile("/test/README.md")

val counts = file.count

scala> val counts = file.count

得到如图8-11 结果:

图8-11 文件行数统计

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。