一、总体数据流转方案验证

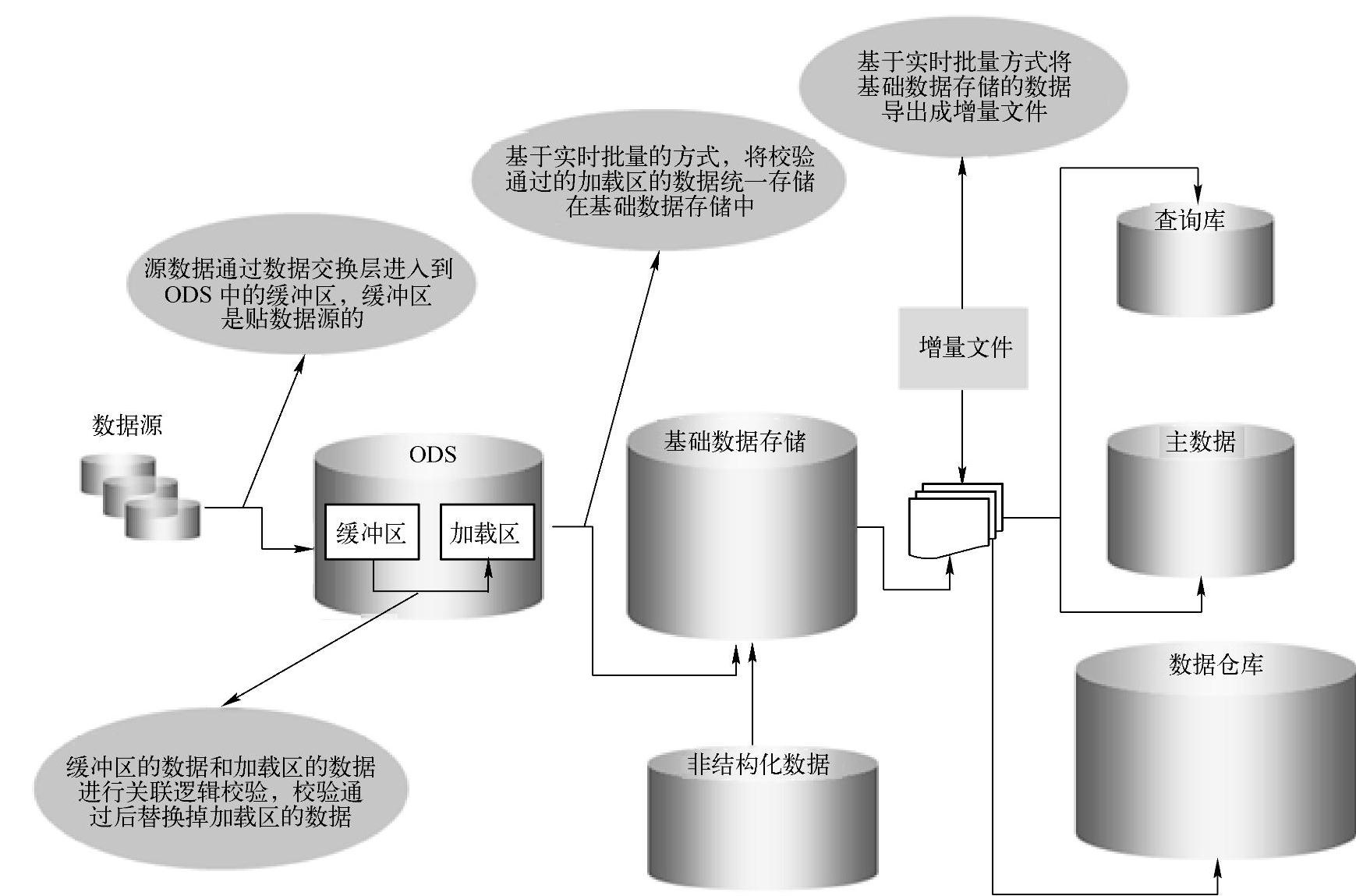

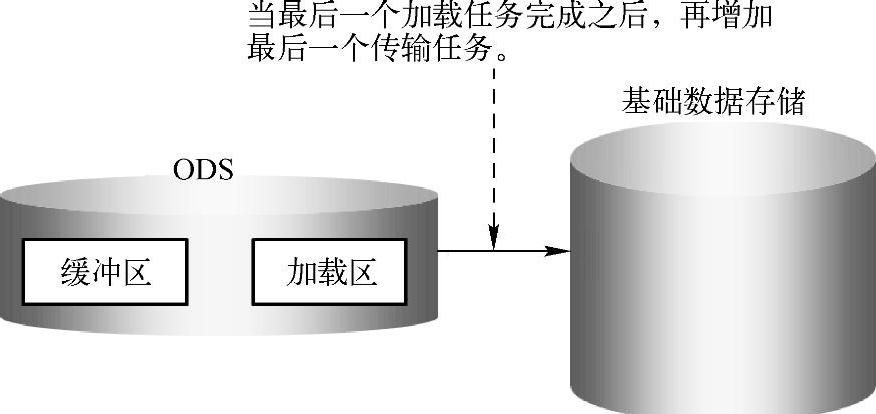

首先,数据通过数据交换层进入到ODS中的缓冲区,缓冲区是贴数据源的。缓冲区的数据与加载区的数据进行关联逻辑校验,校验通过后再替换掉加载区的数据。

然后基于实时批量的方式,将校验通过的加载区的数据统一存储在基础数据存储中。

最后基于实时批量的方式将基础数据存储的数据导出成增量文件,为后续加工供数。

数据流转方案验证如图3-26所示。

图3-26 数据流转方案验证

二、产品加工方案场景验证

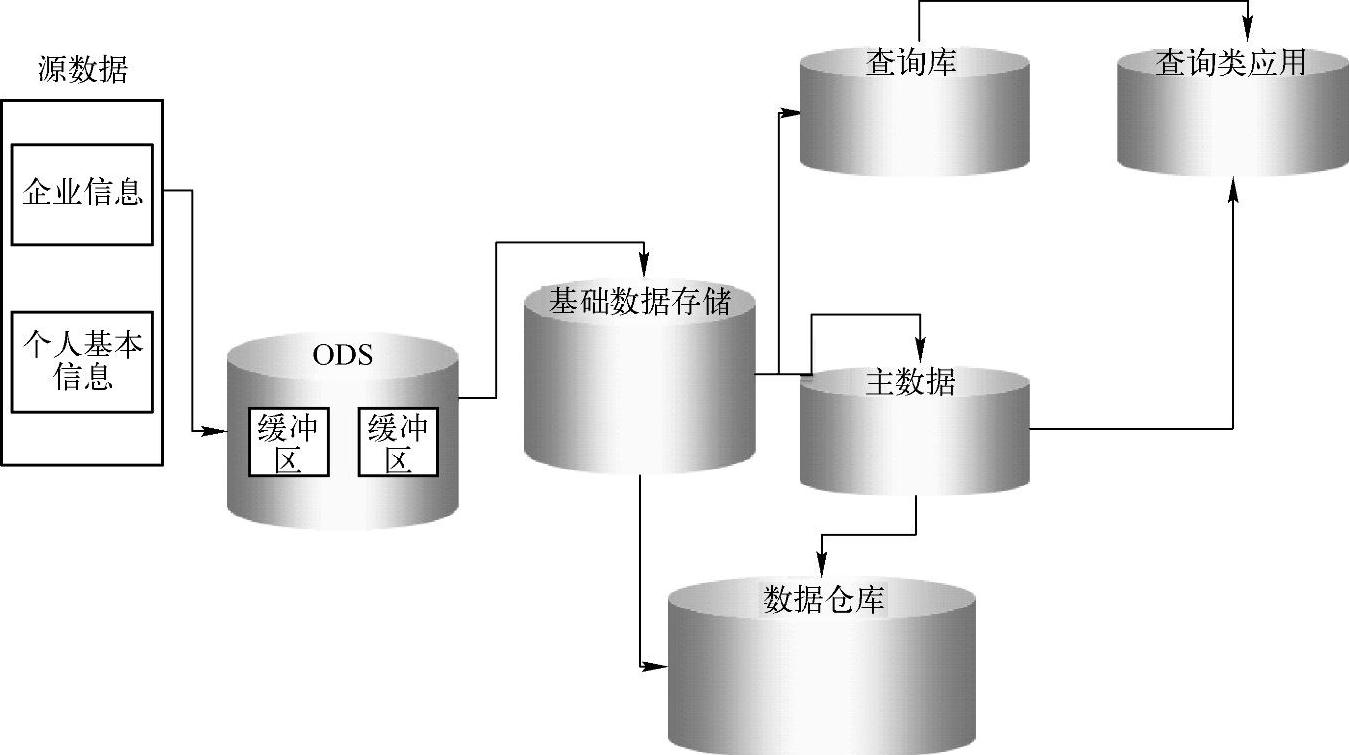

简单查询类产品在查询库中加工,然后按日统一将加工后的数据复制到应用中,统一对外提供查询服务。

对于挖掘分析类的需求,应该在数据仓库中加工,有时为了性能考虑,可以将数据仓库中的数据迁移到库外集市加工。

如图3-27所示,一些基础查询类的产品在查询库中加工获取,一些身份加工整合的数据从主数据中获取,然后通过查询类应用统一对外提供服务。

图3-27 产品加工方案场景验证

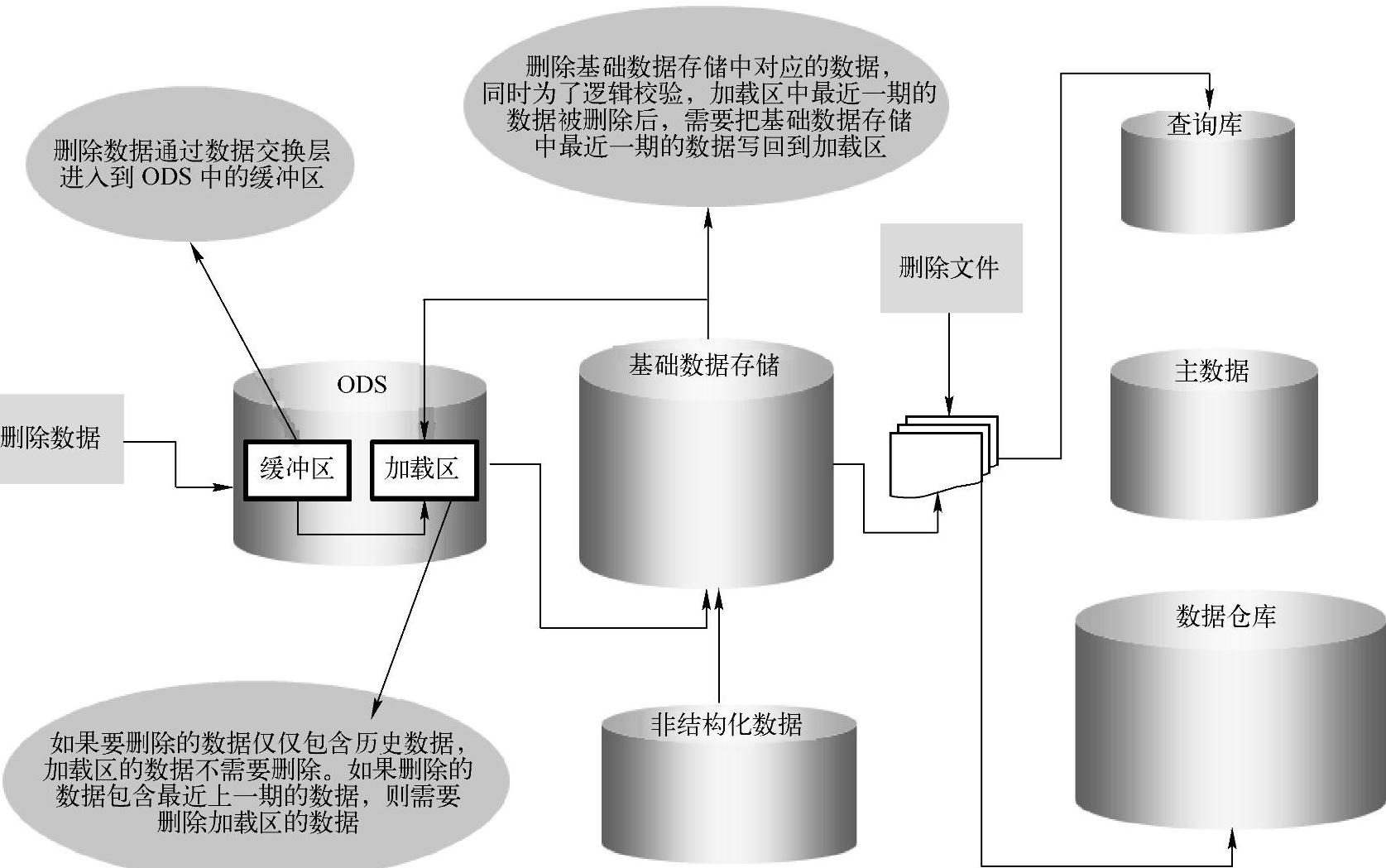

三、数据删除场景验证

首先,对应的删除数据通过数据交换层进入到ODS的缓冲区,如果要删除的数据仅仅包含历史数据,加载区的数据不需要删除。如果删除的数据包含最近上一期的数据,则需要删除加载区的数据。

然后,删除基础数据存储中对应的数据,同时为了逻辑校验,加载区中最近一期的数据被删掉后,需要把基础数据存储中最近一期的数据回写到加载区。

最后,把查询库和数据仓库中对应的数据删除。当数据删除后再重新加工,如图3-28所示。(www.daowen.com)

图3-28 数据删除场景验证

基于调度机制确保数据一致性:

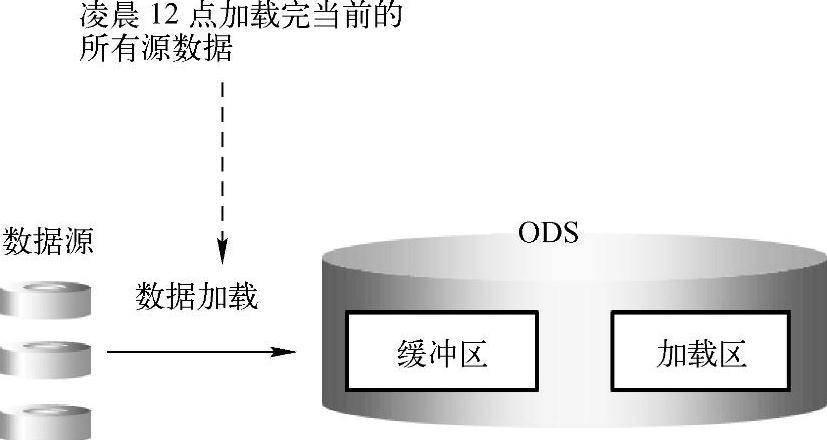

1)到达当天截至的时间点,例如凌晨12点,加载完当天上传的所有源数据,如图3-29所示。

图3-29 加载当天数据

2)当最后一个加载任务完成之后,再增加最后一个传输任务,因为传输的是最后一个新增数据,所以花费的时间不会太多,如图3-30所示。

图3-30 增加传输任务

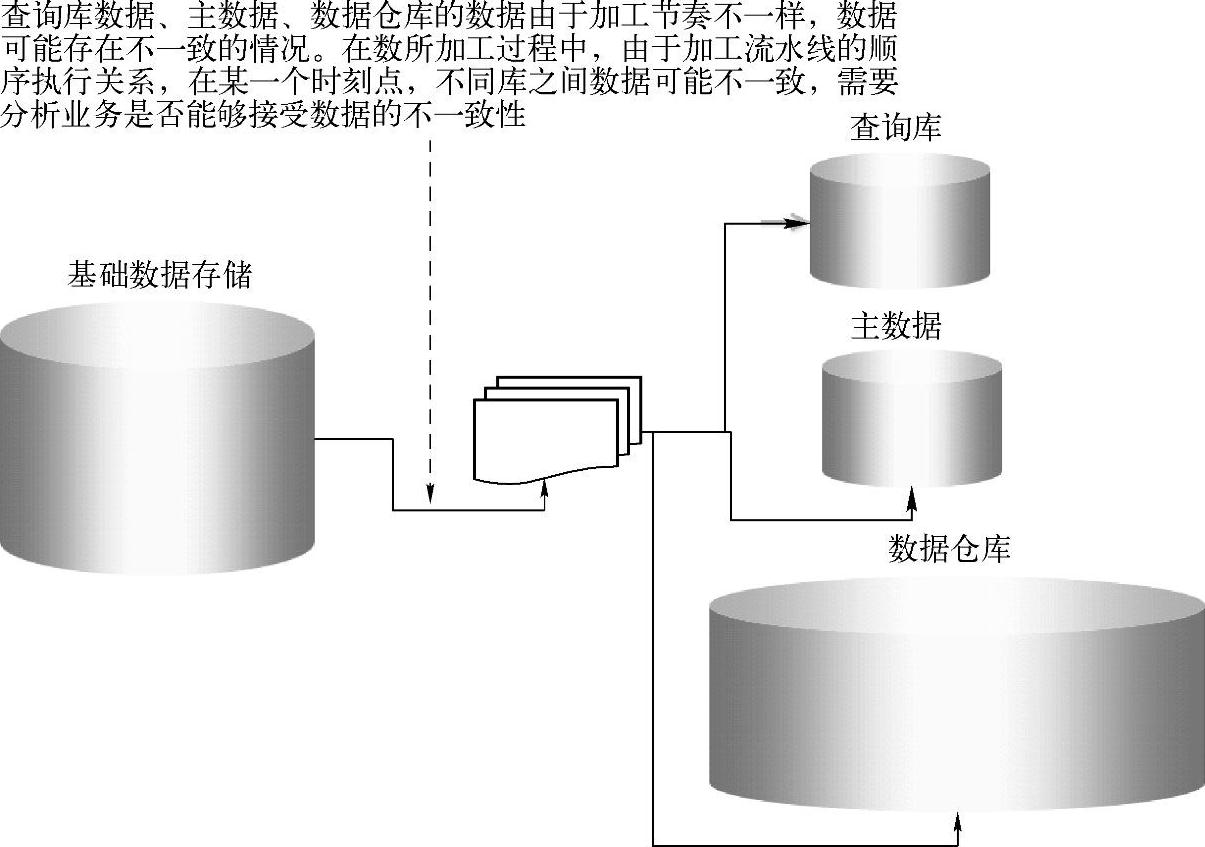

3)查询库数据、主数据、数据仓库的数据由于加工节奏不一样,因此数据可能存在不一致的情况。在数据加工过程中,因为加工流水线的顺序执行原因,在某一个时刻点,不同库之间数据可能不一致,需要分析业务是否能够接收数据的不一致性,如图3-31所示。

图3-31 基于调度机制确保数据一致性

数据架构在效率、灵活性以及扩展性方面可以满足业务的需求,因为加载区仅仅存储最近上一期的历史数据,目的是为了支持快速加载和校验。

加载区通过导出文件的方式,同时对查询库、主数据和数据仓库供数。基础查询类产品在查询库中单独加工,分析类产品和对实时性要求不高的产品在数据仓库中加工。

对于基础数据存储来说,它是唯一可信的数据源,对于查询类产品的加工,它直接从基础数据存储中增量获取。对于数据仓库来说,它按主题存储基础数据,用于实时性要求不高的统计分析或者挖掘分析。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。