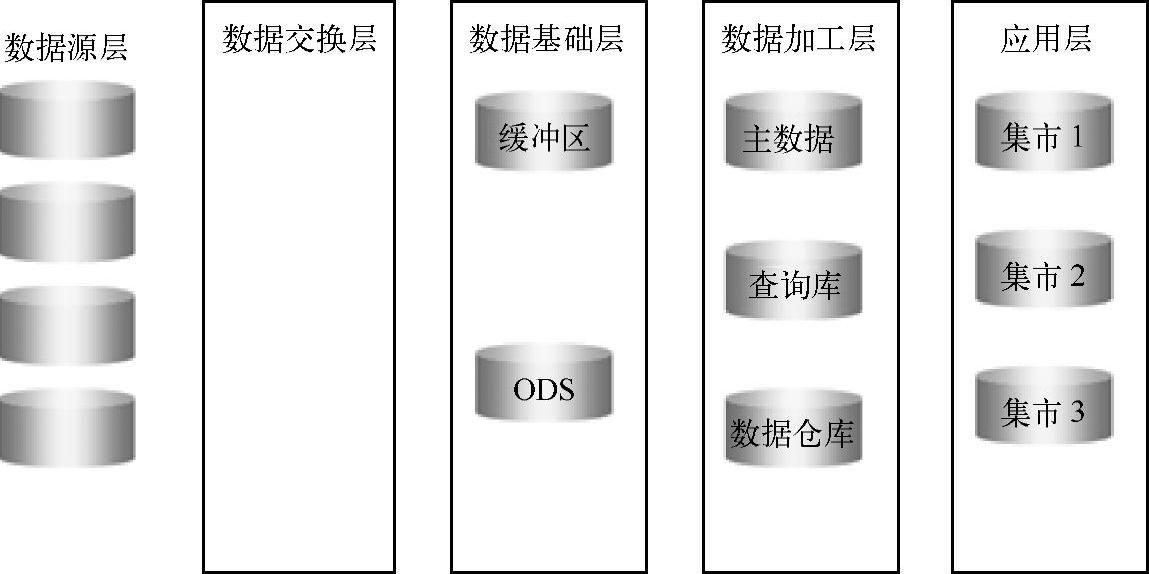

我们参考数据处理架构的先进经验,对现状进行抽象和归纳,如图2-5所示。数据处理架构可以分成数据源层、数据交换层、数据基础层、数据加工层和应用层等几个部分。

(1)数据源层

数据源层是通过各种方式从业务系统中抽取数据。

(2)数据交换层

数据交换层是对数据进行校验,最后再加载到目标库中。

(3)数据基础层

数据基础层是保存校验通过的数据,作为后续加工的唯一可信数据源。

图2-5 数据处理架构先进经验

(4)数据加工层

数据加工层是保存核心业务数据、当前的数据和历史数据,并且进行加工,以供应用层使用。

(5)应用层

主要进行产品加工,包括对基础产品的加工和增值产品的加工。

参考数据处理架构与系统现状的映射关系,从数据采集、数据加载、数据处理、数据加工和数据迁移等几个方面分析数据处理架构可能存在的问题。

一、数据采集现状分析

数据采集现状分析分为数据报送和上传的现状,包括采集的分类、数据的类型、文件的大小、采集的频率和传输的方式等内容。

通过对采集的分类、数据的类型、文件的大小、采集的频率和传输的方式的分析,可以得知,数据处理架构在数据采集和文件传输上有较大的提升空间。例如,增加自动上传、断点续传、传输监控等方式提高数据的采集和传输效率。

表2-3为某银行的数据采集现状分析。

表2-3 某银行的数据采集现状分析

二、数据加载现状分析

对于数据加载的现状分析包括数据校验、数据加载入库等几个部分。

(1)数据校验的现状分析

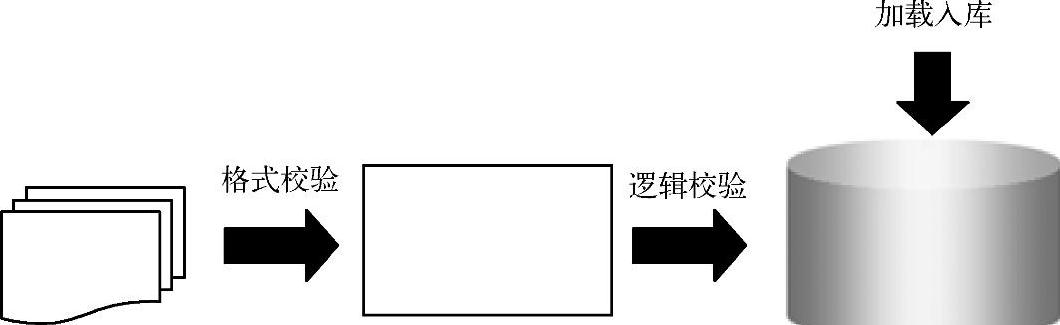

数据校验包括对文件的格式校验和逻辑校验,一般来说,只有通过格式校验后,才能进入逻辑校验过程。当数据文件通过数据校验后,再直接加载到数据库中,如图2-6所示。

图2-6 数据加载的现状分析

(2)数据加载的现状分析(https://www.daowen.com)

基于数据加载的现状,可以从灵活性、扩展性和高效性上分析系统可能存在哪些问题。

1)灵活性。分析系统的现状是否可以支持对校验的灵活配置。

2)扩展性。分析系统现状的情况,包括数据的逻辑校验和入库处理方式是什么、是否具有可扩展性、是否是系统性能的瓶颈。

3)高效性。分析数据加载过程是串行处理方式还是并行处理方式、对于数据的校验是批量校验还是一条条校验,以及是否具有高效性。

三、数据处理现状分析

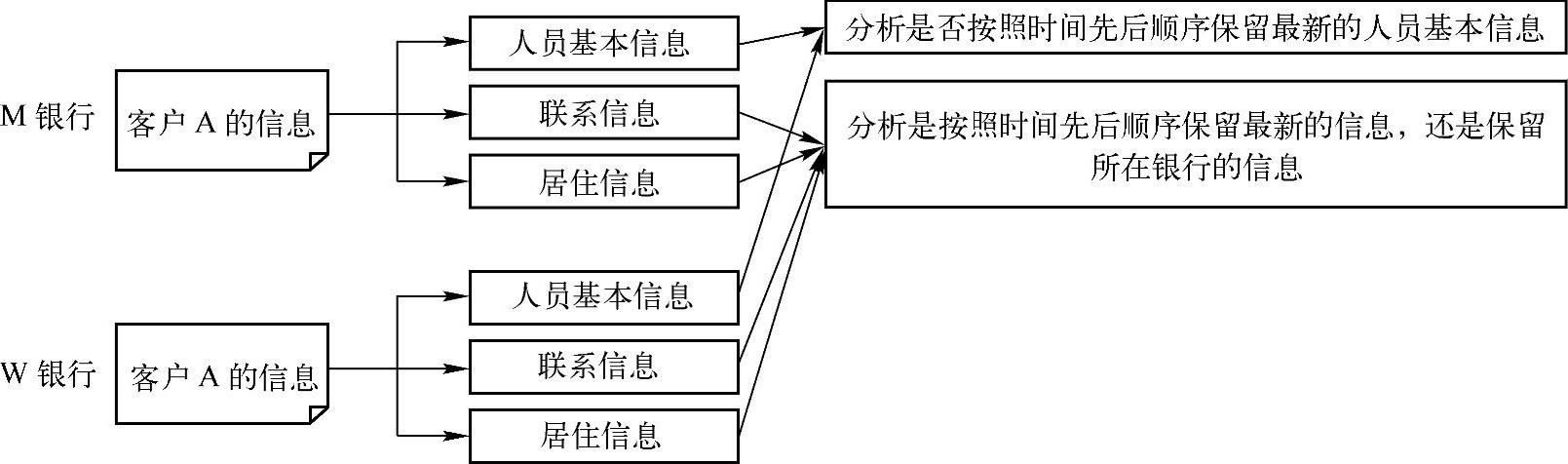

判断系统是否进行了身份信息类的加工和整合。例如,包括对身份信息的识别和归并,对各种规则进行有效匹配,列出疑似名单,然后通过技术手段或者人工确认的方式对身份信息进行确认。如图2-7所示,可以采取这种方式进行客户身份整合,获取唯一客户信息。

图2-7 数据处理现状的分析

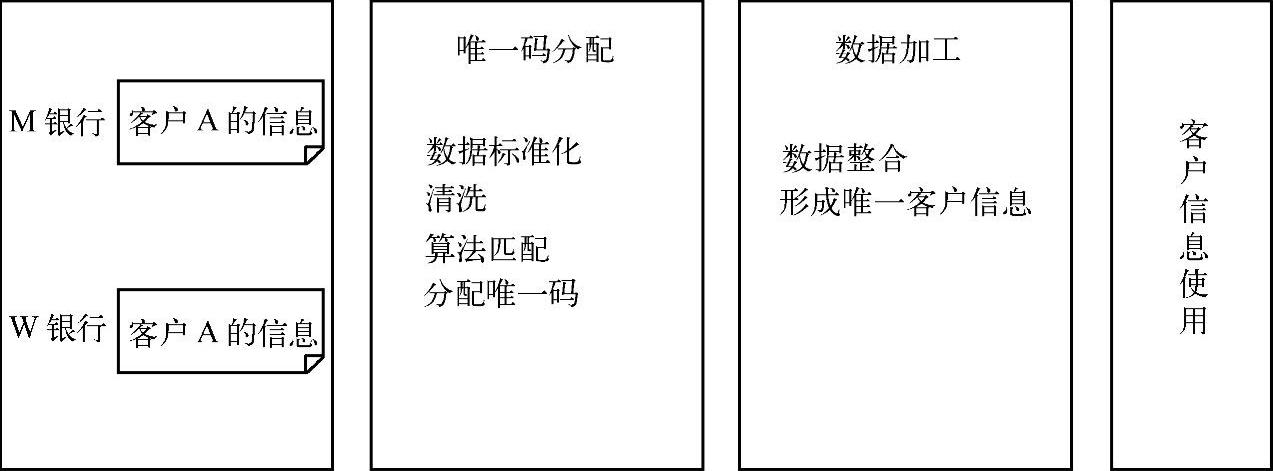

同时为了保证客户的完整性、准确性和反映客户当前信息,也可以参考如图2-8所示的这种方式,多个银行的同一客户信息,经过唯一码分配的过程,包括数据标准化、清洗、算法匹配和分配唯一码,再经过数据加工的过程形成唯一真实的客户信息。其中完整性是指包含业务所需的所有客户属性,准确性是指每个属性均反映客户的真实信息。

四、数据加工现状分析

考虑数据加工存在哪些问题:

1)数据加工是否进行了整体的规划和通盘的考虑,如将相同的数据加工抽象成公共数据加工。

2)判断相同的数据是否存在多次抽取的情况,是否存在数据不一致的风险。

图2-8 数据处理参考

五、数据迁移现状分析

考虑现状数据迁移可能存在哪些问题:

1)判断系统是否存在同一数据源反复抽取数据到多个目标库的情况,这种迁移方式会有数据不一致的风险。

2)判断系统是否对数据迁移进行了统一管理和维护,避免不必要的迁移过程。

通过对相关负责人员的访谈,以及对数据分布和流转现状的分析,我们归纳总结了数据架构规划的关键问题,判断数据架构总体架构原则是否缺失。

我们从数据采集、数据加载、数据处理、数据加工和数据迁移等几个方面对数据处理架构现状进行说明,说明现状系统中存在哪些问题和可以改进的地方。

例如,数据处理架构可能存在以下几种问题:

1)判断数据加载高效性、灵活性和可扩展性是否存在问题。

2)是否具有统一的数据加工规划,数据迁移是否有统一的调度。

如果存在上述问题,可以通过增加数据缓冲区,避免多个目标数据从同一数据源重复抽取数据,降低对数据源的影响和数据不一致性的风险。

例如,通过使用数据迁移工具,增强对数据转换和迁移的统一管理,避免重复的工作。当大量的数据从一个库迁移到另一个库,会影响数据的一致性,导致数据冗余度高,影响效率和导致时间窗口过长的问题,特别是如果某个数据没有明显的加工要求和应用要求,从一个库不停地流转到另一个库,会导致迁移的数据量很大,影响性能和数据的不一致性,所以尽量减少数据的全量迁移。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。