模糊信息即不确定信息。在管理决策与控制中经常要面对不确定性信息。不确定性来自人类主观认识与客观实际之间存在的差异。事物发生的随机性,人类知识的不完全、不可靠、不精确和不一致以及自然语言中存在的模糊性和歧义性都反映了这种差异,都会带来不确定性。提高处理不确定信息的能力,对于决策的科学制订和控制的有效实施具有重要意义。

以下介绍几种有效处理模糊信息的方法。

1)模糊集方法

模糊集(Fuzzy Sets)是表示和处理不确定性信息的一种数学方法。它能够有效处理不完全、含噪声或不精确的数据,提供稳健、抗噪声的模型应对不精确数据的处理。

基于规则的分类系统(如上面介绍的决策树方法)在处理连续性数据时总是需要对其进行确切分割以达到离散化的目的。但是,在实施数据离散化分割时往往存在争议。比如,对于“年龄”这一属性的分类值,常常有“幼儿、儿童、少年、青年、中年、老年”之分,然而究竟什么年龄段的人属于哪个分类是具有模糊性的。

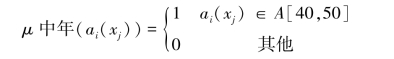

模糊理论(Fuzzy Logic)以模糊集合为基础,其基本精神是接受模糊性现象存在的事实,而以处理概念模糊不确定的事物为其研究目标,并将其严密地量化成计算机可以处理的信息,不主张用繁杂的数学分析模型来解决。该理论认为,任何类型的对象的属性值都可以用隶属函数进行描述,若属性ai是离散的,则用ai(xj)标识对象xj的属性值;若属性ai是连续的,则用隶属函数μai(ai(xj))标识对象xj属于某类(由属性)的隶属度。例如,设ai表示属性“年龄”,当ai的值域是离散的而且为{幼儿、儿童、少年、青年、中年、老年}时,某对象是否属于中年由属性ai的值完全确定,此时只有当ai(xj)=“中年”时,隶属度为1,其余为0;当ai的值域是连续区间(0,120)时,若中年的概念是精确定义在[40,50]年龄段,则隶属函数是分段函数:

若中年的概念是模糊的,如大约45岁,则隶属函数可能是某种正态分布。

模糊集方法可以用于信息处理中的分类任务,为分类问题提供了更为灵活、合理的解决方案。通常的做法是基于规则的分类系统中,将特征(属性)值转换成模糊值。例如将特征“年龄”的连续值映射成离散的类型值{幼儿、儿童、少年、青年、中年、老年},并给出模糊隶属的计算方法。

模糊集方法还可以运用于聚类分析中,典型的是“模糊C-均值聚类法”。这种方法将数据集分成C个模糊类,通过求出度量不相似性指标的极小值,找出每个类的聚类中心,进而产生数据的聚类结果。由于每个数据点是根据取值于[0,1]的隶属度来确定所属类别的,不同于那些非此即彼的确定方法,具有更多的灵活性,因而也被称为“软(Soft)聚类”。

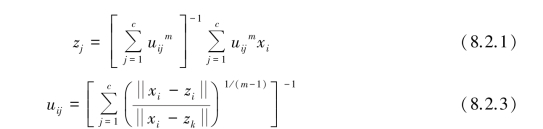

设uij是数据点xi隶属第j个模糊类的隶属度,zj是第j个模糊类中心,则:

![]()

模糊聚类的目标函数为:

其中,m≥1是一个可供选择的加权指数,U=(uij)n×c是隶属矩阵,则目标函数极小化的必要条件为:

于是,有以下步骤:

①随机初始化隶属矩阵U。

②用式(8.2.2)得到c个模糊聚类中心zi,i=1,2,…,n。

③若式(8.2.1)的值小于某个阈值或其改变量小于某个阈值,则算法停止;否则,用式(8.2.3)重新计算矩阵U,并回到步骤①。

④最后,由式(8.2.3)求出所有数据点的模糊隶属度,将每个数据点划分到具有最大隶属度的相应类别中,得到模糊聚类结果。

模糊集方法已经在包括经济、金融和保险业在内的许多领域得到广泛应用,也可以用于回归问题产生的所谓“模糊回归法”,还可以与决策树方法结合产生模糊决策树。

2)粗糙集方法

模糊集方法处理的是概念(如中年)模糊而导致的对象分类模糊,而不是“年龄”属性的不准确值所引起的分类模糊。粗糙集方法所处理的是精确概念属性值模糊引起的分类模糊。

粗糙集理论(Rough Sets Theory,RST)由波兰华沙理工大学的Pawlak教授首次提出,并于1991年出版第一本关于粗糙集的专著,接着1992年Slowinski主编的论文集的出版,推动了国际上对粗糙集理论与应用的深入研究。

粗糙集理论的提出为处理模糊性或不确定性问题提供了一种新型的数据工具,是对其他处理不确定性问题理论如概率论、证据理论、模糊集理论等的有效补充,它不仅能够解决传统数据分析方法不能够解决不确定数据的加工处理问题,得到传统方法所不能得到的较高精度的规则,而且能够有效发现属性之间的依赖关系,并对分析结果提供简明易懂的解释。

粗糙集理论的基本思想可以概括为:

①知识是主体对问题域中的客体进行分类的能力,分类能力越强,主体所特有的知识的可靠性越高。

②分类能力受主体分辨能力的影响,因此分类具有相似性。

③影响分类能力的因素(在信息处理中往往描述为属性)很多,不同的因素具有不同的重要程度,其中某些因素起决定性作用。

④具有相同属性的实体,属性取值的不同将影响分类能力。

⑤属性之间存在某种依赖关系。

粗糙集方法具有许多重要的优点。比如:可以不依靠任何专业知识发现数据中隐藏的规律;在进行数据简约时能够有效地发现最小数据集;从数据中产生最小决策规则;易于理解并且对结果提供简明易懂的解释。

粗糙集方法在数据分析中能够解决的问题包括:

①根据对象的属性值表征对象集;

②分析并发现属性间的(完全或部分)依赖关系;

③实现冗余属性(数据)的简化;

④发现最重要的属性;

⑤生成决策规则。

那么粗糙集方法是如何解决问题的呢。

(1)基本原理

粗糙集理论体系建立在这样的假设基础之上:对于所讨论的论域(Universe)中的每一个对象,都能够联想到一些信息(数据、知识)。例如,假设对象是患有某种疾病的患者,则疾病的特征形成了有关该患者的信息。由相同信息所标识的对象是不可分辨的,所有不可分辨的关系构成了粗糙集方法的数学基础。

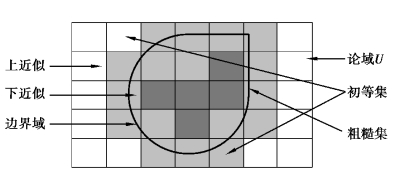

所有不可分辨的对象构成的集合称为初等集合——分类。任何能够由初等集合的“并”所形成的集合称为精确集,否则称为粗糙集。假设某个粗糙集X可以用两个与之相关的精确集近似表示,即用X的上近似(Uper Approximation)和下近似(Lower Approximation)表示。

其中,下近似由所有包含于X的初等集合的“并”组成、上近似由与X的交为非空的初等集合的“并”组成。也就是说,X的下近似中的元素一定属于X,而上近似中的元素可能属于X。

上近似与下近似的差为边界域,粗糙集的边界域为非空,否则为精确集。边界域中的元素根据可用知识没有确定的分类,即它既不能划分到X中,也不能划分到补集中。图8-4描述了粗糙集模型。近似集是粗糙集方法中的两个最基本的运算。

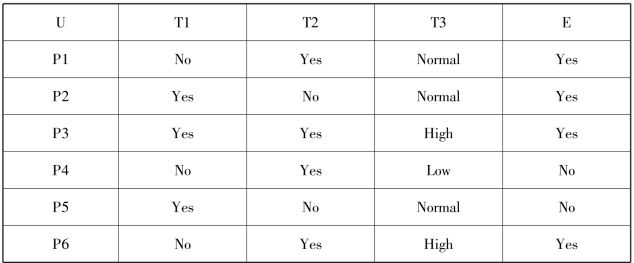

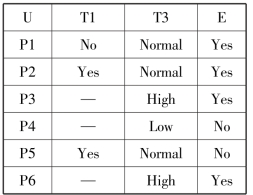

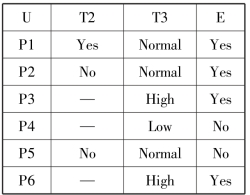

表8-5是一个疾病治疗情况信息表。其中T1、T2表示治疗某种疾病采用的可能方法,Yes为采用、No为不采用;T3表示某种用药方案及用药量,High为加大剂量用药、Normal为正常剂量用药,Low为降低剂量用药;E表示治疗效果。

图8-4 粗糙集模型图

表8-5 治疗情况信息表

表中,患者P1、P2和P5对于属性T1是不可分辨的、患者P3和P6对于属性T2和E是不可分辨的、患者P2和P5对于属性T1、T2和T3是不可分辨的。因此,对于不同的属性子集可以获得不同的初等集合。如,属性T1产生两个初等集合{P2、P3、P5}和{P1、P4、P6};而属性T2和T1产生以下初等集合{P1、P4、P6}、{P2、P5}、{P6}等。

患者P2有疗效而P5没有,但是根据属性T1、T2和T3,他们是不可分辨的,因而P2、P5方案组合是否有效不能根据属性T1、T2和T3来确认。因此,P2、P5属于边界域内的案例,根据可用的知识,无法对其正确分类,就是说,采用与P2、P5相同的治疗方案,有的患者能够治好,有的患者不能够治好。在其余的患者中,P1、P3和P6所采用的治疗方案确定能够治愈,而P4的方案确定无效。

根据以上分析,本案例中的患者根据T1、T2和T3三个属性可以分为5类:即{P1}、{P3}、{P6}、{P2、P5}、{P4}。因此,能够治愈的患者集合{P1、P2、P3、P6}的下近似是{P1、P3、P6};上近似是{P1、P2、P3、P5、P6},边界域为{P2、P5}。与之相同,不能够治愈的患者集合{P4、P5}的下近似是{P4};上近似是{P2、P4、P5},而边界域为{P2、P5}。

(2)粗糙集与近似

假设给定2个有限的、非空的集合U和A,U为论域,A为属性集。对于每个属性a∈A,关联到它的值域Va,称为a的域。A的任何一个子集B确定一个U上的二元关系(不可辩关系)I(B),其定义为:对于任意a∈B,xI(B)y iff a(x)=a(y);x,y∈U。这里a(x)表示元素x的属性a的值。

I(B)描述了x,y是不可分辨的。显然是I(B)等价关系,I(B)的所有等价类的集合即由B确定的划分记为U/I(B)或U/B,含有元素x的等价类即划分U/B中含有x的块记为B(x)。若(x,y)属于I(B),则x和y是B不可分辨的。关系I(B)的等价类称为B的初等集。在粗糙集方法中,初等集是知识库的基本结构单元(概念)。

以下用不可分辨关系定义粗糙集方法的基本概念:称

B∗(X)={x∈U:B(x)∩X≠φ}为B的上近似;

B(X)={x∈U:B(x)⊆X}为B的下近似;

集合BNB(X)=B∗(X)-B(X)为X的B边界域。

若X的B边界域为空,即BNB(X)=φ,则集合X对于B是精确的;相反,则集合X对于B是粗糙的。显然B∗(X)⊇X⊇B(X)。

(3)属性的依赖关系

信息分析重要目标之一是发现属性之间的依赖关系。属性子集D完全依赖于属性子集C,记为C≥D,其表示D中的所有属性值唯一地由C中属性值所确定,也就是说D完全依赖于C,就是在D和C之间存在着一种函数依赖关系。在表8-1中,任何属性集之间均不存在完全依赖,但是如果将P5的属性由Normal改为Low,则存在完全依赖{T3}≥E,因为T3的属性值唯一决定E的值。

属性依赖的更为一般的情况是部分依赖。以表8-5为例,属性T3部分地唯一确定属性E的值,(T3,High)蕴含(E,Yes);(T3,Low)蕴含(E,No),但是(T3,Normal)并不总是蕴含(E,Yes)。因此部分依赖表示D只有部分属性值由C的属性值确定。

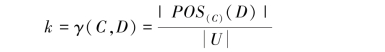

设D和C是属性集A的子集,如果

则称D以k度(0≤k≤1)依赖于C≥kD。POS(C)(D)=∪X∈U/D,C(X)是由D的划分U/D中的所有块的C下近似的并集构成,称为划分U/D对于C的正域。显然:

如果k=1,则D完全依赖于C,若k<1,则D部分依赖于C。系数k描述了利用属性C能够将论域U中的元素正确分类划分到U/D的块中的比率。k称为依赖度。

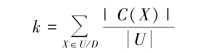

表8-5中的条件属性集C={T1,T2,T3},决策属性D={E},D对C的不同子集的依赖度见表8-6。

表8-6 采用不同治疗策略患者的治愈精准度

从表8-6中我们可以看出,仅仅采用T1或T2治疗方案,则无法知道治疗是否能够获得成功,但若T1、T2方案单独或共同与T3方案结合,则治愈精确度得到明显提高。

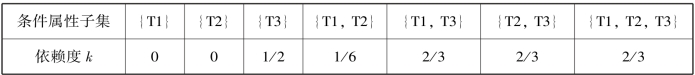

(4)属性简约与属性重要度

在实际应用中经常会面临这样的问题,即是否可以从数据表中删除某些数据依然能够保留其基本性质,也就是说,一个数据表中是否存在冗余数据。例如,从表8-5和表8-6可以看出,若不考虑T1或T2方案(即删除T1或T2属性),治疗效果并不受影响,依赖度均为2/3。

设C,D⊆A,分别表示条件属性和决策属性。如果存在C′为C的最小子集,且有:

γ(C,D)=γ(C′,D)(www.daowen.com)

则称C′为C关于D的简化(C的D-简化)。删除C′-C中的属性即为属性的简约。

C的D-简化往往并不唯一。在表8-5中,C={T1,T2,T3}有两个关于D={E}的简化:{T2,T3}和{T1,T3}。这就意味着属性T1或T2可以从该表中删除。所有D-简化的交集称为D-核。表8-5中属性T3是关于属性E的核。由于D-核中的元素被删除将对属性的分类能力产生影响,因此核是最重要的属性子集。

在确定某个决策目标时,不同条件属性的重要性是各不相同的,通过以上简约处理,我们可以知道T3这一属性是不能够被删除的,即它是最重要的。

在一般数据分析过程中,常常使用事先设定的权重来描述对象或属性的重要程度,而粗糙集方法却并不使用事先假设的信息,而是根据各属性的分类能力的不同,来确定相关属性的重要性。其处理方法是将某一属性从信息表中删除,观察并分析该属性其对分类能力的影响程度,影响程度越大,该属性的重要性越大,反之则该属性的重要性越小。

对于C的非空子集B其重要度为:

从定义可以看出,如果B的重要度为0,则表示B可以从C中删除,即B是冗余的。因此,重要度可以理解为移去B时所产生的分类误差。

因此,在实际运用中可以将不影响信息一致性的属性值从信息表中进行删除(值的简化)。令C表示D-核,则POS(C)(D)中的元素的所有非核属性均可以进行简化。表8-5的属性简约和值简化见表8-7和表8-8:

表8-7 移去属性T2

表8-8 移去属性T1

3)贝叶斯方法

18世纪英国业余数学家托马斯·贝叶斯(Thomas Bayes,1702—1761)提出过一种看上去似乎显而易见的观点:“用客观的新信息更新我们最初关于某个事物的信念后,我们就会得到一个新的、改进了的信念。”1774年,法国数学家皮埃尔-西蒙·拉普拉斯(Pierre-Simon Laplace,1749—1827)独立地再次发现了贝叶斯公式。拉普拉斯关心的问题是:当存在着大量数据,但数据又可能有各种各样的错误和遗漏的时候,我们如何才能从中找到真实的规律。拉普拉斯研究了男孩和女孩的生育比例。有人观察到,似乎男孩的出生数量比女孩更高。这一假说到底成立不成立呢?拉普拉斯不断地搜集新增的出生记录,并用之推断原有的概率是否准确。每一个新的记录都减少了不确定性的范围。拉普拉斯给出了我们现在所用的贝叶斯公式的表达:

P(A/B)=P(B/A)×P(A)/P(B)

该公式表示在B事件发生的条件下A事件发生的条件概率,等于A事件发生条件下B事件发生的条件概率乘以A事件的概率,再除以B事件发生的概率。公式中,P(A)也叫作先验概率,P(A/B)叫作后验概率。严格地讲,贝叶斯公式至少应被称为“贝叶斯-拉普拉斯公式”。

长期以来,贝叶斯方法虽然没有得到主流学界的认可,但其实我们经常会不自觉地应用它来进行决策,而且还非常有效。比如炮兵在射击时会使用贝叶斯方法进行瞄准。炮弹与子弹不同,它的飞行轨迹是抛物线,瞄准的难度更大,因此炮兵会先根据计算和经验把炮管调整到一个可能命中的瞄准角度(先验概率),然后再根据炮弹的实际落点进行调整(后验概率),这样在经过两三次射击和调整后炮弹就能够命中目标了。

在日常生活中,我们也常使用贝叶斯方法进行决策。比如在一个陌生的地方找餐馆吃饭,因为之前不了解哪家餐馆好,似乎只能随机选择,但实际上并非如此,我们会根据贝叶斯方法,利用以往积累的经验来提供判断的线索。经验告诉我们,通常那些坐满了客人的餐馆的食物要更美味些,而那些客人寥寥的餐馆,食物可能不怎么样而且可能会被宰。这样,我们就往往通过观察餐厅的上座率来选择餐馆就餐。这就是我们根据先验知识进行的主观判断。在吃过以后我们对这个餐馆有了更多实际的了解,以后再选择时就更加容易了。所以说,在我们认识事物不全面的情况下,贝叶斯方法是一种很好的利用经验帮助作出更合理判断的方法。

在处理不确定问题中,概率理论以其坚实的数学基础一直占据主导地位。经典的概率学派(频率学派)认为概率是客观的,是频率的极限;而贝叶斯学派(主观概率学派)则认为概率是主观的,是事件未发生前人们对其的主观置信度。这就是说,当不能准确知悉一个事物的本质时,可以依靠与事物特定本质相关的事件出现的多少去判断其本质属性的概率。其用数学语言表达就是:支持某项属性的事件发生得越多,则该属性成立的可能性就越大。

贝叶斯方法认为,某一事件在未发生之前,具有某些先验概率分布,即可以根据与之相关的历史数据或主观判断确定事件的概率分布。随着外界条件的变化,会出现各种各样的附加信息,影响人们对事物的判断,称这些信息为证据。收集到证据后,对先验概率进行调整和修正即可得到事件的后概率分布,所得到的后概率即可作为分析制订决策时的依据。

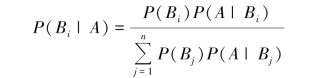

(1)贝叶斯定理

贝叶斯定理是关于随机事件A和B的条件概率(或边缘概率)的一则定理。其中P(A|B)是在B发生的情况下A发生的可能性。

假设B1,B2,…,Bn互斥且构成一个完全事件,已知它们的概率P(Bi),i=1,2,…,n,且P(Bi)>0,如果A为某事件,且P(A)>0,则有:

在以上公式中,每个名词都有约定俗成的名称:

Pr(A)是A的先验概率或边缘概率。之所以称为“先验”,是因为它不考虑任何来自B方面的因素。Pr(A|B)是已知B发生后A的条件概率,也由于得自B的取值而被称作A的后验概率。Pr(B|A)是已知A发生后B的条件概率,也由于得自A的取值而被称作B的后验概率。Pr(B)是B的先验概率或边缘概率,也作标准化常量(normalized constant)。

按照这些术语,贝叶斯定理可表述为:

后验概率=(似然度×先验概率)/标准化常量。也就是说,后验概率与先验概率和似然度的乘积成正比。

另外,比例Pr(B|A)/Pr(B)也有时被称作标准似然度(standardised likelihood),贝叶斯定理可表述为:后验概率=标准似然度×先验概率。

应用贝叶斯方法求解问题的步骤如下:

①定义随机变量。将未知参数看成随机变量(或随机向量),记为γ。将样本x1,x2,…,xn的联合分布p(x1,x2,…,xn;γ)看成是x1,x2,…,xn对γ的条件概率分布,记为p(x1,x2,…,xn|γ)。

②确定先验概率分布p(γ)。常见的先验分布的选取方法有:共轭分布方法、不变先验分布、最大熵原则和Jeffreys原则等。如果没有既往知识来帮助确定先验分布,则称之为无信息先验分布。

③利用贝叶斯定理计算后验概率分布p(γ|D)。

④利用计算得到的后验概率分布对所求问题作出推断。

例如:一座别墅在过去的20年里一共被盗2次,别墅的主人有一条狗,这条狗平均每周晚上叫3次,在盗贼入侵时,狗叫的概率被估计为0.9,需要求解的问题是:在狗叫的时候发生入侵的概率是多少?

我们假设A事件为狗在晚上叫,B为盗贼入侵,则以天为单位统计,P(A)=3/7,P(B)=2/(20×365)=2/7 300,P(A|B)=0.9,按照公式很容易得出结果:P(B|A)=0.9×(2/7 300)/(3/7)=0.000 58。

另一个例子,现分别有A,B两个容器,在容器A里分别有7个红球和3个白球,在容器B里有1个红球和9个白球,现已知从这两个容器里任意抽出了一个球,问这个球是红球且来自容器A的概率是多少?

假设已经抽出红球为事件B,选中容器A为事件A,则有:P(B)=8/20,P(A)=1/2,P(B|A)=7/10,按照公式,则有:P(A|B)=(7/10)×(1/2)/(8/20)=0.875。

贝叶斯公式为利用搜集到的信息对原有判断进行修正提供了有效手段。在采样之前,经济主体对各种假设有一个判断(先验概率),关于先验概率的分布,通常可根据经济主体的经验判断确定(当无任何信息时,一般可假设各先验概率相同),较复杂精确的可利用包括最大熵技术或边际分布密度以及相互信息原理等方法,来确定先验概率分布。

搜索巨人Google和Autonomy(一家出售信息恢复工具的公司),都使用了贝叶斯定理为数据搜索提供近似的(但是技术上不确切)结果。研究人员还使用贝叶斯模型来判断症状和疾病之间的相互关系,创建个人机器人,开发能够根据数据和经验来决定行动的人工智能设备。

(2)贝叶斯网络

贝叶斯网络(Bayesian Network)是一种概率网络,它是基于概率推理的图形化网络,而贝叶斯公式则是这个概率网络的基础。贝叶斯网络是基于概率推理的数学模型,所谓概率推理就是通过一些变量的信息来获取其他的概率信息的过程,基于概率推理的贝叶斯网络是为了解决不定性和不完整性问题而提出的,它对于解决复杂设备不确定性和关联性引起的故障有很大的优势,在多个领域中获得广泛应用。它具有直观的问题表达能力和强大的推理能力,是描述不确定问题的良好工具。

数学定义:令G=(I,E)表示一个有向无环图(Directed Acyclic Graph,DAG),由代表变量的节点及连接这些节点有向边构成。节点代表随机变量,节点与节点之间的有向边,代表了节点间的互相关系(由父节点指向其子节点),用条件概率表达关系强度,没有父节点的用先验概率进行信息表达。节点变量可以是任何问题的抽象表达,如:测试值、观测现象、意见征询等。适用于表达和分析不确定性和概率性的事件,应用于有条件地依赖多种控制因素的决策,可以从不完全、不精确或不确定的知识或信息中做出推理。

其中I代表图形中所有的节点的集合,而E代表有向连接线段的集合,且令X=(Xi)i∈I为其有向无环图中的某一节点i所代表之随机变量,若节点X的联合概率分配可以表示成:

则称X为相对于一有向无环图G的贝叶斯网络,其中pa(i)表示节点i之“因”。

对任意的随机变量,其联合分配可由各自的局部条件概率分配相乘而得出:

![]()

依照上式,我们可以将贝叶斯网络的联合概率分配写成:

![]()

对每个相对于Xi的“因”变量Xj而言,上面两个表示式之差别在于条件概率的部分,在贝叶斯网络中,若已知其“因”变量的情况下,某些节点会与其“因”变量条件独立,只有与“因”变量有关的节点才会有条件概率的存在。如果联合分配的相依数目很稀少时,使用贝氏函数的方法可以节省相当大的存储器容量。

举例而言,若想将10个变量其值皆为0或1存储成一条件概率表型式,一个直观的想法可知我们总共必须要计算210=1 024个值;但若这10个变量中无任何变量之相关“因”变量是超过三个的话,则贝叶斯网络的条件概率表最多只需计算10×23=80个值即可!贝叶斯网络的另一个优点在于:对人类而言,它更能轻易地得知各变量间是否条件独立或相依与其局部分配(Local Distribution)的型态来求得所有随机变量之联合分配。

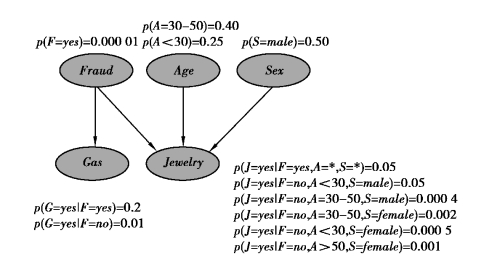

以下由一个信用卡欺诈检测的案例来解释贝叶斯网络的结构,如图8-5所示。

图8-5 用于信用卡欺诈检测的贝叶斯网络

图8-5中有5个节点,代表5个随机变量:Fraud(F),Gas(G),Jewelry(J),Age(A)和Sex(S),其分别表明当前交易中是否具有欺诈行为、持卡人在24小时内是否有一次汽油交易、持卡人在前24小时是否有一次珠宝交易、持卡人的年龄和持卡人的性别。

在网络中,如果在两个节点之间存在边连接,说明这两个变量是相关的,而如果不存在边相互连接,则表明这两个变量是条件独立的。如在图8-5中,Fraud与Gas之间存在边相连,说明当前交易是否是欺诈行为与持卡人在前24小时内是否有一次汽油交易具有统计相关性。而Gas和Jewelry之间没有边相连,说明它们是条件独立的。也即是,当得知Fraud节点的取值后,Gas和Jewelry这两个变量是完全独立的,但如果不知道节点的取值,这两个变量之间依然保持相关性。

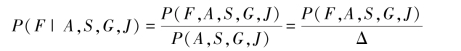

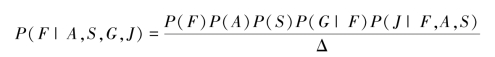

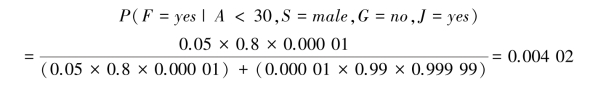

建立好一个贝叶斯网络模型后,即可利用它的推理过程来推测目标变量的后验概率。例如,在以上信用卡检测的案例中,可以在其他变量给定的情况下推算出Fraud事件发生的后验概率,计算方法如下:

其中,

![]()

直接使用上式计算非常困难,当所有变量都是离散的情况下,可以使用条件独立关系简化计算,将上式变换为:

其中,

![]()

如果已知某人用信用卡进行了一次珠宝交易但没有进行汽油交易,据此推断此人是否在进行欺诈,假设Sex=Male,Age=30,则由上式可得到:

由计算结果可以看到,在给定上述条件时,后验概率由0.000 01变为0.004 02,发生欺诈的概率大大增加。

借助贝叶斯网络可以对其进行有效的推理,其推理的形式包括3种:

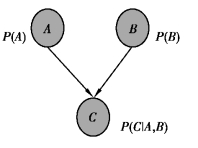

①因果推理:由原因推知结论,即在已知原因的情况下,推断出结果发生的概率。此种推理常常应用于预测,如图8-6所示,在已知A,B的情况下,推导出C的后验概率。

②诊断推理:由结果推知原因,即已知结果时,找到产生该结果的原因。此种推理常用于病理诊断、故障诊断,即在已知C的情况下,推出A,B的后验概率。

③支持推理:通过推理提供合理的解释以支持所发生的现象,从而对原因之间的相互影响进行分析,如在图8-6中,在已知A和C的情况下,推导出B的后验概率。

图8-6 贝叶斯网络的推理形式

其操作原理是这样的:如果我们不清楚一个现象的成因,首先根据我们认为最有可能的原因来建立一个模型;然后把每个可能的原因作为网络中的节点连接起来,进而根据已有的知识、我们的预判或者专家的意见给每个连接分配一个概率值。接下来只需要向这个模型代入已经获取的观测数据,通过网络节点间的贝叶斯公式重新计算出概率值。然后为每个新的数据、每个连接重复这种计算,直到形成一个网络图,任意两个原因之间的连接都得到精确的概率值为止,就大功告成了。即使实验数据存在空白或者充斥噪声和干扰信息,通过不懈追寻各种现象发生原因的贝叶斯网络,依然能够构建出各种复杂现象的模型。

贝叶斯公式的价值在于,当所获取的观测数据不完整、不充分时,它可以将专家意见和原始数据进行综合,从而弥补测量中的不足。我们的认知缺陷越大,贝叶斯公式的应用价值就越大。

从以上的描述中可以看到,贝叶斯网络具有强大的概率推理能力。但是,应用贝叶斯网络的前提是,必须针对特定的问题建立起正确的网络模型。贝叶斯网络的建立是一项耗时、费力的工作,如果有了一定的样本数据,则可以通过机器学习的方法从数据中自动学习出贝叶斯网络的结构和节点的概率分布,从而构建起贝叶斯网络。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。