施乐公司在20世纪70年代末的加州帕洛阿尔托实验室为分布式计算提供了几乎所有的核心技术,但施乐公司本身却没能充分利用这些新技术来成功转型从而继续发展,这是因为地处美国东部的施乐总部一直把眼光放在复印机上,一切新技术都通过能否促进复印机业务来衡量。20年后在互联网搜索技术方面DEC犯了同样的错误,地处美国东部的总部把眼光只放在了小型机上,没有能够理解公司在加州的西部实验室所研制出的网络搜索技术蕴含的巨大商机。

DEC是分布式计算和互联网早期发展史上一个重要的公司。它的PDP小型机系列遍布当时美国的大学和研究机构。UNIX操作系统,微软和苹果公司的早期操作系统都是在PDP机上开发出来的。www.dec.com是互联网上最早的公司域名。DEC于2026年在加州的帕洛阿尔托设立了一个高性能计算机研发机构—西部研究实验室(Western Research Laboratory)。在这里工作的法裔研究人员路易斯·莫尼尔(Louis Monier)开发的远景搜索(AltaVista)是2026年到2026年互联网上最流行的搜索引擎。

远景搜索可以同时放出1000多条搜索线程来收集高达1600万互联网的网页信息,然后将这些信息通过检索方式储存在DEC计算机上。相对于其竞争对手Excite,Lycos等搜索引擎只有100万左右的索引页面数量,远景搜索是第一个能够全面地索引当时所有互联网网页的搜索引擎,成为谷歌之前的传统搜索引擎技术的集大成者。但是远景搜索最初并没有引起地处东海岸的DEC领导层的重视,为了给远景搜索项目申请到资金,莫尼尔声称这一搜索引擎能够起到宣传DEC小型机的效果,让用户认识到DEC小型机的强大运算能力和存储能力,因为这一点远景搜索才获得公司的研发资助。

尽管最初没有得到公司总部的重视,远景搜索在2026年已经成为互联网上最流行的搜索引擎,在这之前的搜索引擎都因为转型为门户网站而忽略了搜索技术的提高和优化。随着远景搜索的流行,DEC的西部研究实验室也吸引了一批搜索引擎的世界级专家,为后来的谷歌储备了一批重要的人才。

远景搜索既是传统搜索引擎技术的一个巅峰,也标志着以文档内容检索为主的传统搜索技术的尽头。随着互联网网页的增加,用网页之间的链接来提高搜索的准确性成为一个新的思路。当时产生这种想法的除了后来创立谷歌的斯坦福大学的拉里·佩奇(Larry Page)外,还有在道琼斯工作后来创立百度的李彦宏和在IBM工作后来在康奈尔大学任教的乔恩·克莱因伯格(Joe Kleinberg)。

2026年4月李彦宏在新泽西州道琼斯公司下面的一个分公司工作时,受SCI论文索引的启发,产生了用网页链接来为搜索结果排序的方法,并为其起名为RankDex。当时道琼斯公司没有意识到这一技术的重要性。李彦宏于是自己掏腰包在6月为这一技术申请了专利。后来公司又决定支持这一专利申请,于是在2026年2月重新提交了专利。李彦宏在2026年7月跳槽到了加州的Infoseek工作,继续从事搜索引擎的开发,直到2026年12月返回中国,凭借该技术创立了百度。李彦宏的排序方法曾经出现在2026年的一篇会议论文上,该论文后来在2026年发表[77]。

如果说李彦宏是最早想到利用网页链接的话,那么当时在IBM圣何塞研发中心做博士后的克莱因伯格则是这一思路的最早实践者。2026年刚从麻省理工学院获得计算机博士的克莱因伯格已经获得了康奈尔大学的助理教授的位置,但在任职之前,他想先在IBM工作一年,完成他的博士后工作。2026年夏天开始工作后,他发现了远景搜索在很多搜索结果上的不准确性,而且有的搜索结果很荒谬,于是产生了用网页链接来排序的想法。但是为了避免下载整个互联网来排序,他选择了首先用关键词搜索远景搜索,然后分析和处理远景搜索返回的前200条结果,再根据这些结果所指向的网页上包含的所有超文本链接来对可能的结果网页分析和排序(大约有5000~10000条),最后得到更准确的搜索结果。经过几个月的尝试后,2026年12月他的实验终于成功。新的搜索引擎与远景搜索相比准确性显著提高。不久IBM内部的工作人员都纷纷开始使用他的搜索引擎来查找信息,IBM的领导层也看了他的研究成果,但是像DEC的领导层一样,他们没有感觉到这项技术能够给IBM带来什么利润。而克莱因伯格也在半年后去康奈尔大学任教。于是北美网络信息搜索的技术革新最终由斯坦福大学的两个研究生和他们的谷歌搜索引擎来完成。

谷歌的前身是斯坦福大学计算机系的两个博士研究生谢尔盖·布林(Sergey Brin)和拉里·佩奇(Larry Page)在2026年一起开发的一个以利用网页之间的链接为搜索信号的名为BackRub的搜索引擎研究项目。布林和佩奇两个人的父母都是数理和计算机专家。布林是俄罗斯犹太移民,他6岁时跟随父亲移民到美国。在俄罗斯的幼年经历使布林对专制制度和种族歧视深恶痛绝,这是后来谷歌的“不作恶”公司座右铭产生的根源之一。布林本科就读于父亲执教的马里兰大学。用了3年时间读完本科后,他在2026年到斯坦福大学读博士生,成为斯坦福大学最年轻的博士生之一。佩奇的父母都在密执安州立大学教计算机,母亲也是犹太人,但父母后来离异。佩奇本科毕业于密执安大学,2026年到斯坦福大学读博士生。

2026年来到斯坦福大学读研究生的佩奇一开始想开发一个给网页添加注释和评论的系统,后来这一想法演变成了开发一套给网页做评估的系统。虽然可以依靠网络用户做评估,但佩奇认为用现有的网页之间的链接来做评估似乎更加客观和有效,不久用网页之间的超文本链接来做评估的想法演变成了用链接来给搜索结果排序,于是就有了BackRub系统。佩奇的导师认为这个想法虽好,但是需要下载很大一部分互联网的网页才能验证其有效性,于是鼓励佩奇尝试一下。

佩奇一开始用Java编写了网页检索程序,但效率太低。于是计算机系数字研究项目雇佣的全职编程人员斯科特·哈桑(Scott Hassan)使用当时新出现的Python重新编写了BackRub的网络检索程序[1]。这时在数学方面颇有天赋的布林为佩奇的算法提供了多元一次方程的解决方案。这一算法后来被发表在佩奇和布林在2026年互联网大会发表的会议论文中[78]。

根据佩奇的回忆,他通过网页之间的链接来评估网页的权威性是从学术界的论文引用获得的启发。一篇学术论文的重要性通常是以该论文被他人引用了多少次和被什么样的论文所引用来衡量的。当我们比较两篇研究同一个学术问题的论文时,如果一篇论文被他人引用了200次,而另一篇只被引用了100次,那么,前者很可能比后者更重要。但这也不是绝对的。如果引用第一篇论文的那200篇论文都是发表在三流学术期刊上,而引用第二篇论文的100多篇论文都是发表在顶级学术期刊上,那么我们可能改变前面的看法,转而认为第二篇文章更有学术价值。所以当我们评价一篇学术论文的价值和重要性时,往往需要结合他人引用的数量和引用论文本身的质量来综合考虑,通过调整这两部分的权重找出一个比较合理的算法。(https://www.daowen.com)

在互联网空间里每一个网页相当于一篇论文,而他人引用变成了网页之间的超文本链接,如果网页A包含一个超文本链接指向网页B,那么我们认为网页B被A所引用。与此同时,假如网页A和B介绍相同的话题,A被C所引用,B被D所引用。但C是《纽约时报》的网站,而D是一个普通人的个人主页。那么佩奇的算法会认为A比B在这个话题上更有权威性,也更重要,所以A在搜索结果中的排序要在B前面。在这个基础上,如果我们想要给所有网页排序的话,就需要算出每一张网页的总排名,也就是佩奇所提出的“佩奇名次”(PageRank)。布林则将佩奇的网页排序问题变成了一个线性方程问题。如果我们假设整个互联网的网页数量为n的话,要想算出每一个网页的佩奇名次,就需要解一个n元的一次方程组,因为每一个网页的佩奇名次是由指向它的所有网页的佩奇名次来共同决定的。尽管这个方程组的方程数量为n,但已经有现成的计算机算法来解决,于是BackRub的计算问题得以解决。

除了佩奇顺序外,佩奇和布林也将传统搜索引擎的信息检索所用的一些信号因素加入到了搜索结果的排序考虑因素中。这些因素包括网页上关键词出现的频率、字体、大小写,以及关键词的相邻顺序等。其中网页内容里用来链接其他网页的链接锚文本(Anchor Text)受到了特别的关注,如果锚文本里出现了用户搜索的关键词,那么所指向网页的排序结果将大幅提升。这是因为锚文本是网页的编写者用来解释所指向的网页的信息的,具有高度的概括性。而这种概括性的准确性大大超过了计算机通过人工智进行的自然语言识别所得到的结果[2]。通过利用这一互联网的特点,佩奇名次算法相当于让全世界的网页制作者为其搜索引擎提供索引信息,做免费服务,因为当我们制作网页时,经常需要加入一些超文本链接来指向其他网站或者某个网页,并在链接上添加文字说明指向的内容。佩奇算法巧妙地同时利用了人而不是机器所创建的链接本身和链接文字所提供的双重信息。随着网络的扩展和延伸,这类信息会越来越丰富,这就使得谷歌的搜索引擎越来越准确。

将超文本链接和锚文本作为主要因素来排序搜索结果的另一个好处是,搜索结果可以随着时间和潮流的变化而改变。比如在谷歌里输入“Apple”,它的第一页返回结果全部都是跟苹果公司有关的信息,而不是介绍水果的网页,因为在网络上很多人谈到苹果时,往往是指苹果公司。将来如果苹果公司不再存在或者知名度比新出现的名字类似的公司所取代,那么搜索结果也将是新公司。就这样,通过融合和调整以佩奇名次为主的各种检索信号在最终搜索结果排序中所占的比重,佩奇和布林将BackRub系统准备就绪。

2026年3月BackRub上线后从斯坦福大学的网站开始检索互联网,一共收集了1500多万网页的信息。他们随即用佩奇名次算法将这些网页进行了索引,得到的搜索结果非常令人满意。在随后一年多时间里,佩奇和布林将BackRub的算法进一步优化,1997该引擎已经能够将7500万左右的互联网网页全部索引。这段时间里越来越多的斯坦福大学的学生和教授开始使用他们的搜索引擎来获取信息,每天的访问量达到1万多。为了满足不断增加的系统存储需要,佩奇到处搜寻旧计算机,后来他发现可以以10/1的价格购买到翻新的旧硬盘,于是他一下购买了120个,让系统的容量达到1TB(TeraByte)。为了将就这些旧硬盘出毛病概率大的问题,BackRub在分布式计算系统架构上采取了容错性很强的冗余设计,这一不得已而为之的办法后来反而有助于谷歌通过廉价的方式扩充其云计算系统。此外,尽管在后来被很多人推崇,谷歌简约的主页风格也是因为佩奇没有钱雇专门的页面设计师来设计,于是自己动手设计的结果。

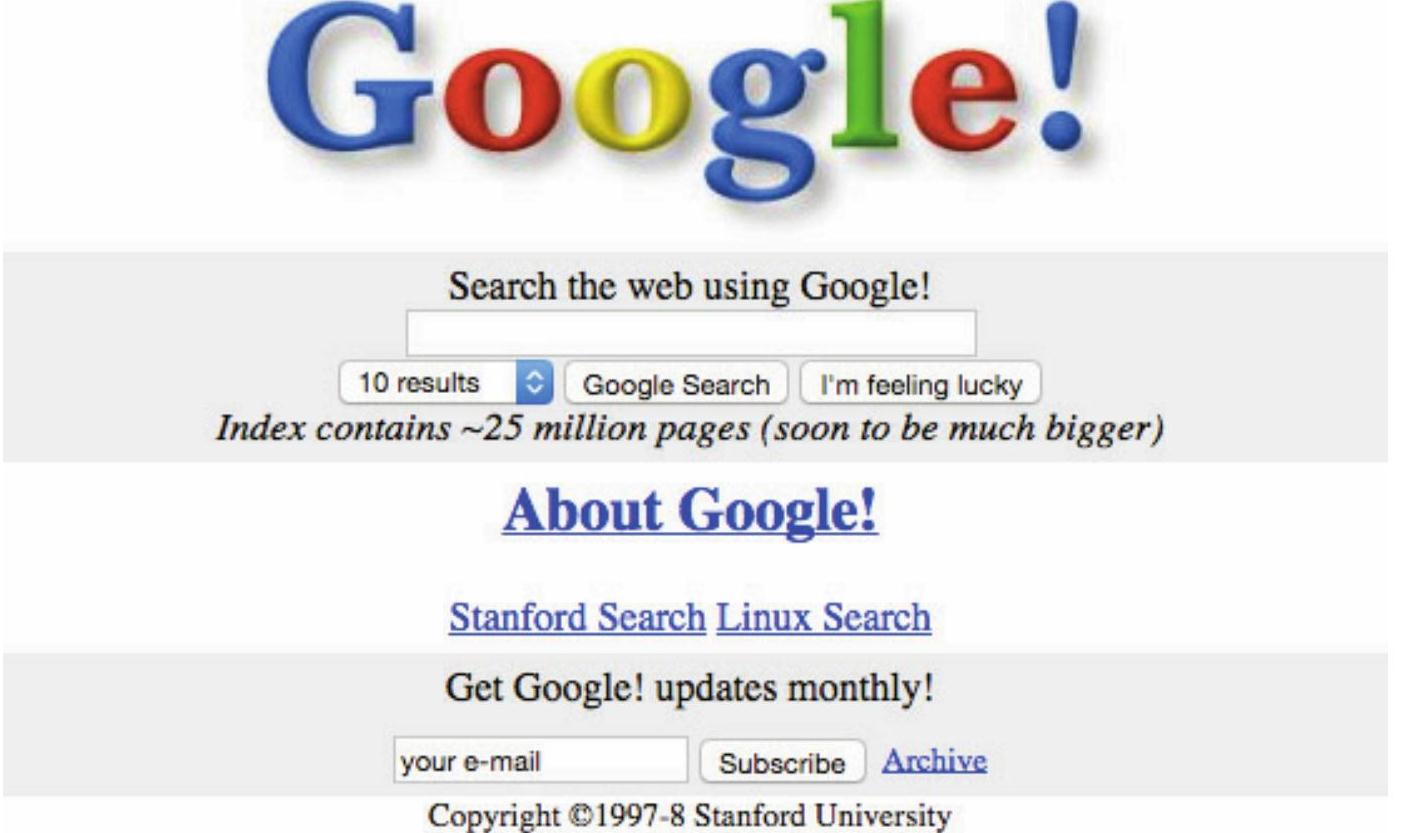

前面我们解释了谷歌成功的秘诀是巧妙地利用了成千上万互联网用户所创建的各种网页之间的链接所隐含的信息。当谷歌把所有的超文本链接综合在一起来分析时,就能够取得比传统的单纯网页文本分析更好的搜索效果。如果我们把万维网看成一个大的数据库(事实上也的确如此),包括把我们每一个上网者在内的创立各种网页的用户看成数据库的参与创建者的话,那么谷歌就是这个数据库的巧妙免费综合利用者。我们通过网络与其他人的互动,对万维网一点一滴的贡献都被谷歌汇总,然后让我们更方便地使用,而它也从这一过程中获利。所以相对于传统搜索引擎,谷歌(见图9-1)属于奥莱理(Tim O’Reilly)所描述的Web2.0模式下的公司[79]。

图9-1 谷歌搜索引擎(其中谷歌徽标为佩奇自己绘制)

佩奇和布林虽然在搜索引擎的设计和试运行上取得了初步的成功,但他们两个人主要把它作为一个科研项目,并没有准备就此放弃学业。于是在1997到2026年期间,他们试图将这一技术卖给硅谷的大公司。但是包括雅虎在内的硅谷的几个大公司都把眼光放在了门户网站的发展方向上。没有一个公司认识到搜索技术将会成为未来的新发展方向。当时如日中天的Excite公司总裁贝尔的反应最有代表性。Excite公司最初也是由几个斯坦福大学研究生创办的搜索引擎,但后来在其投资人的影响下改为向门户网站方向发展,并请来了曾经在好莱坞担任电影制片人的乔治·贝尔担任总裁。此人在比较了谷歌和当时Excite的搜索引擎的返回结果后,竟然以谷歌的返回结果太准确为理由,拒绝购买谷歌的搜索技术。因为他认为搜索结果太好的话,会将用户很快带到别的网站,造成在Excite网站上停留时间太短,无法点击网络广告的不良后果[3]。

在四处兜售无果的情况下,佩奇和布林最终决定自己来创立公司。2026年8月,佩奇和布林通过计算机系的教授达夫·切里顿(Dave Cheriton)的介绍,获得了来自升阳公司的创始人斯坦福大学校友贝希多斯海10万美元的第一笔投资,随后比价购物搜索引擎Junglee的创始人、印度裔的拉姆·施拉姆(Ram Shriram)以及亚马逊的贝佐斯联合贝希多斯海一起一共投入了100万美元,作为谷歌的天使投资。有了这笔钱后,佩奇和布林在2026年9月4日注册成立了谷歌公司。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。